1. Cython 是什么?为什么会有 Cython?

作者:古明地觉

公众号:古明地觉的编程教室

公众号二维码:

Cython 估计很多人都听说过,它是用来对 Python 进行加速的。如果你在使用 Python 编程时,有过如下想法,那么 Cython 非常适合你。

- 1)因为某些需求导致不得不编写一些多重嵌套的循环,而这些循环如果用 C 语言来实现会快上百倍,但是不熟悉 C 或者不知道 Python 如何与 C 进行交互;

- 2)因为 Python 解释器的性能原因,如果将 CPython 解释器换成 PyPy,或者干脆换一门语言,比如 Rust,将会得到明显的性能提升,可是换不得。因为你的项目组规定只能使用 Python 语言,解释器只能是 CPython;

- 3)Python 是一门动态语言,但你希望至少在数字计算方面,能够加入可选的静态类型,这样可以极大地加速运算效果。因为单纯的数字相加不太需要所谓的动态性,尤其是当你的程序中出现了大量的计算逻辑时;

- 4)对于一些计算密集型的部分,你希望能够写出一些媲美 Numpy, Scipy, Pandas 的算法;

- 5)你有一些已经用 C、C++ 实现的库,你想直接在 Python 内部更好地调用它们,并且不使用 ctypes、cffi 等模块;

- 6)也许你听说过 Python 和 C 可以无缝结合,通过 C 来为 Python 编写扩展模块,将 Python 代码中性能关键的部分使用 C 进行重写,来达到提升性能的效果。但是这需要你对 Python 解释器有很深的了解,熟悉底层的 Python/C API,而这是一件非常痛苦的事情;

如果你有过上面的一些想法,那么证明你的 Python 水平是很优秀的,然而这些问题总归是要解决的,于是 Cython 便闪亮登场了。注意:Cython 并不是一个什么实验性的项目,它出现的时间已经不短了,并且在生产环境中久经考验,我们完全是有理由学习它的。

下面让我们开始 Cython 的学习之旅吧,悄悄说一句,我个人非常喜欢 Cython 的语法。

1.1 Cython 是什么?

关于 Cython,我们必须要清楚两件事:

1)Cython 是一门编程语言,它将 C 和 C++ 的静态类型系统融合在了 Python 身上。Cython 源文件的后缀是 .pyx,它是 Python 的一个超集,语法是 Python 语法和 C 语法的混血。当然我们说它是 Python 的一个超集,因此你写纯 Python 代码也是可以的。

2)当我们编写完 Cython 代码时,需要先将 Cython 代码翻译成高效的 C 代码,然后再将 C 代码编译成 Python 的扩展模块。

在早期,编写 Python 扩展都是拿 C 去写,但是这对开发者有两个硬性要求:一个是熟悉 C,另一个是要熟悉解释器提供的 C API,这对开发者是一个非常大的挑战。此外,拿 C 编写代码,开发效率也非常低。

而 Cython 的出现则解决了这一点,Cython 和 Python 的语法非常相似,我们只需要编写 Cython 代码,然后再由 Cython 编译器将 Cython 代码翻译成 C 代码即可。所以从这个角度上说,拿 C 写扩展和拿 Cython 写扩展是等价的。

至于如何将 Cython 代码翻译成 C 代码,则依赖于相应的编译器,这个编译器本质上就是 Python 的一个第三方模块。它就相当于是一个翻译官,既然用 C 写扩展是一件痛苦的事情,那就拿 Cython 去写,写完了再帮你翻译成 C。

因此 Cython 的强大之处就在于它将 Python 和 C 结合了起来,可以让你像写 Python 代码一样的同时还可以获得 C 的高效率。所以我们看到 Cython 相当于是高级语言 Python 和低级语言 C 之间的一个融合,因此有人也称 Cython 是 "克里奥尔编程语言"(creole programming language)。

克里奥尔人是居住在西印度群岛的欧洲人和非洲人的混血儿,以此来形容 Cython 也类似于一个(Python 和 C 的)混血儿。

1.2 为什么要有 Cython?

Python 和 C 语言大相径庭,为什么要将它们融合在一起呢?答案是:因为这两者并不是对立的,而是互补的。

Python 是高阶语言、动态、易于学习,并且灵活。但这些优秀的特性是需要付出代价的,因为 Python 的动态性、以及它是解释型语言,导致其运行效率比静态编译型语言慢了好几个数量级。

而 C 语言是最古老的静态编译型语言之一,并且至今也被广泛使用。从时间来算的话,其编译器已有半个世纪的历史,在性能上做了足够的优化,因此 C 语言是非常低级、同时又非常强大的。然而不同于 Python 的是,C 语言没有提供保护措施(没有 GC、容易内存泄露),以及使用起来很不方便。

所以两个语言都是主流语言,只是特性不同使得它们被应用在了不同的领域。而 Cython 的美丽之处就在于:它将 Python 语言丰富的表达能力、动态机制和 C 语言的高性能汇聚在了一起,并且代码写起来仍然像写 Python 一样。

注意:除了极少数的例外,Python 代码(2.x和3.x版本)已经是有效的 Cython 代码,因为 Cython 可以看成是 Python 的超集。并且 Cython 在 Python 语言的基础上添加了一些少量的关键字来更好地开发 C 的类型系统,从而允许 Cython 编译器生成高效的 C 代码。如果你已经知道 Python 并且对 C 或 C++ 有一定的基础了解,那么你可以直接学习 Cython,无需再学习其它的接口语言。

另外,我们其实可以将 Cython 当成两个身份来看待:

- 1)如果将 Cython 翻译成 C,那么可以看成 Cython 的 '阴';

- 2)如果将 Python 作为胶水连接 C 或者 C++,那么可以看成是 Cython 的 '阳'。

我们可以从需要高性能的 Python 代码开始,也可以从需要优化 Python 接口的 C、C++ 开始,而我们这里是为了学习 Cython,因此显然选择前者。为了加速 Python 代码,Cython 将使用可选的静态类型声明并通过算法来实现大量的性能提升,尤其是静态类型系统,这是实现高性能的关键。

1.3 Cython 和 CPython 的区别?

关于 Cython,最让人困惑的就是它和 CPython 之间的关系,但需要强调的是这两者是完全不同的。

首先 Python 是一门语言,它有自己的语法规则,我们按照 Python 语言规定的语法规则所编写的代码就是 Python 源代码。但源代码只是一个或多个普通的文本文件,我们需要使用 Python 语言对应的解释器来执行它。

而 Python 解释器也会按照同样的语法规则来对我们编写的 Python 源代码进行分词、语法解析等等,如果我们编写的代码不符合 Python 的语法规则,那么会报出语法错误,也就是 SyntaxError。如果符合语法规范的话,那么会顺利地生成抽象语法树(Abstract Syntax Tree,简称 AST),然后将 AST 编译成指令集合,也就是所谓的字节码(bytes code),最后再执行字节码。

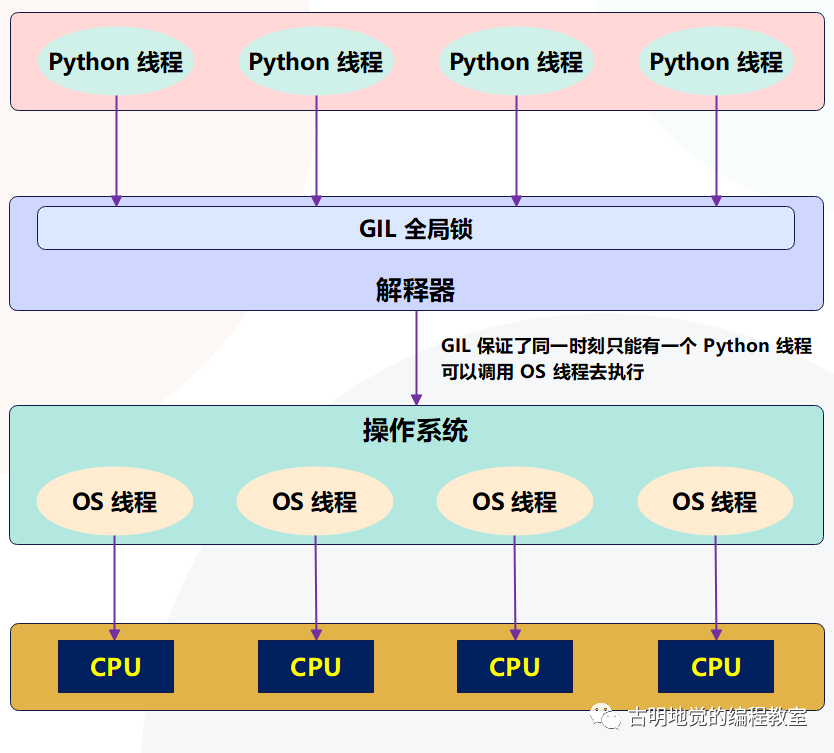

所以 Python 源代码是需要 Python 解释器来操作的,如果我们想做一些事情的话,光写成源代码是不行的,必须要由 Python 解释器将我们的代码解释成机器可以识别的指令进行执行才可以。而 CPython 正是 Python 语言对应的解释器,并且它也是官方实现的标准解释器,同时还是使用最广泛的一种解释器。基本上我们使用的解释器都是 CPython,也就是从官网下载、然后安装之后所得到的。

标准解释器 CPython 是由 C 语言实现的,除了 CPython 之外还有 Jython(Java实现的 Python 解释器)、PyPy(Python 语言实现的 Python 解释器)等等。总之设计出一门语言,还要有相应的解释器才可以;至于编译型语言,则是对应的编译器。

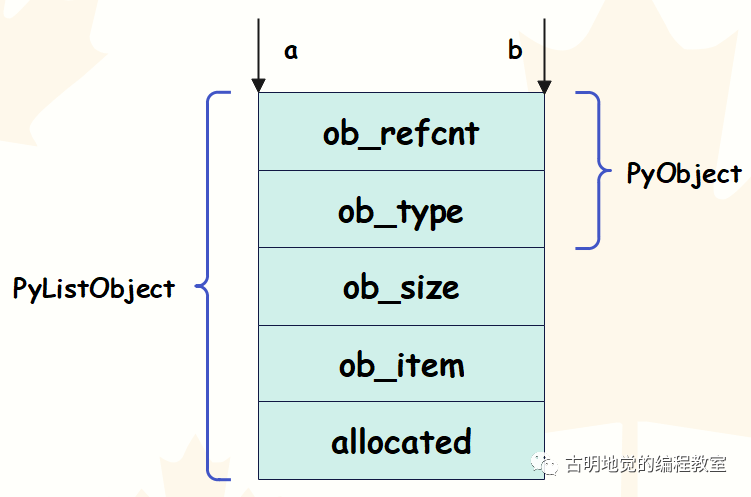

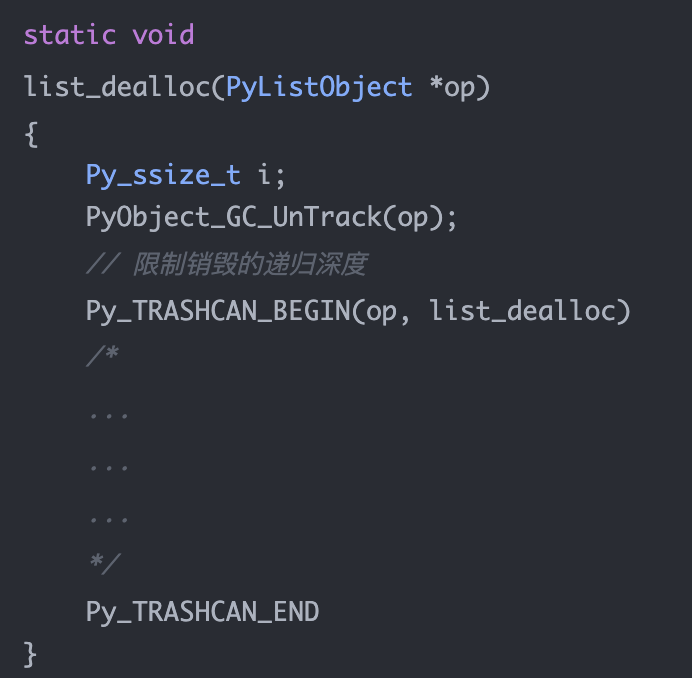

最后重点来了,我们说 CPython 解释器是由 C 实现的,它给 Python 语言提供了 C 级别的接口,也就是熟知的 Python/C API。比如:Python 的列表,底层对应的是 PyListObject;字典则对应 PyDictObject,等等等等。

所以当我们在 Python 中创建一个列表,那么 CPython 在执行的时候,就会在底层创建一个 PyListObject。因为 CPython 是用 C 来实现的,最终肯定是将 Python 代码翻译成 C 级别的代码,然后再变成机器码交给 CPU 执行。

而 Cython 也是如此,Cython 代码也要被翻译成 C 代码,然后 C 代码再变成扩展(本质上也是机器码),导入之后直接执行,而无需动态解释。因此 Cython 是一门语言,它并不是 Python 解释器的另一种实现,它的地位和 CPython 不是等价的,不过和 Python 是平级的。

总结:Cython 是一门语言,可以通过 Cython 源代码生成高效的 C 代码,再将 C 代码编译成扩展模块,同样需要 CPython 来进行调用。

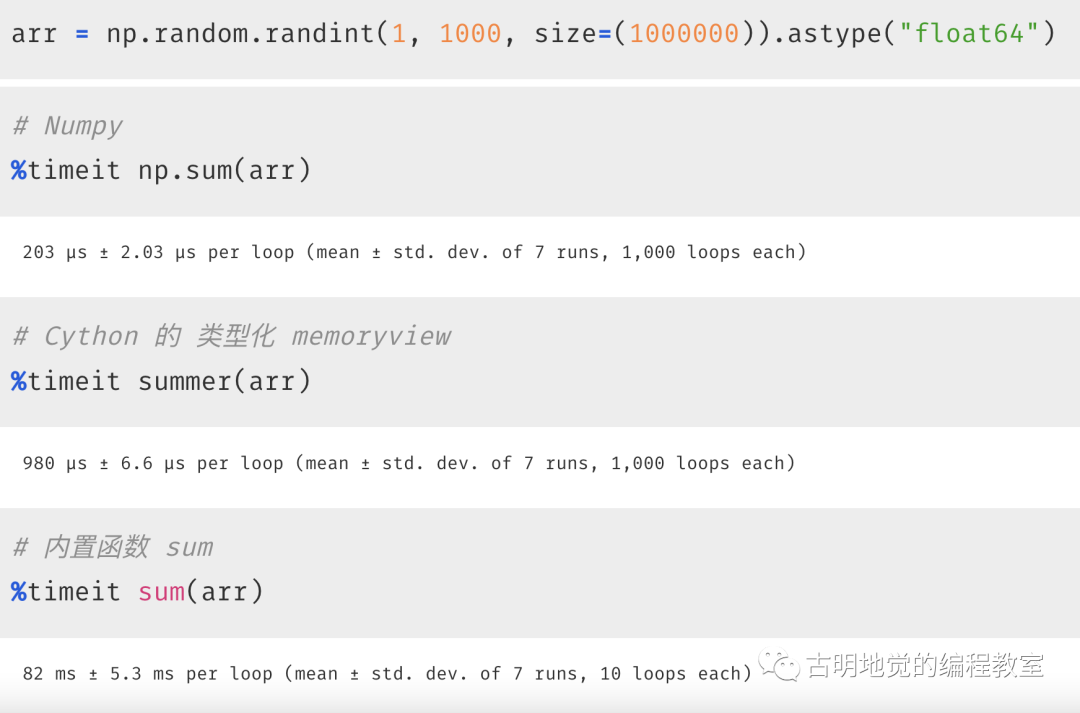

以上我们就解释了什么是 Cython,以及为什么需要 Cython。下面我们来比较一下 Cython、Python、C 扩展、还有原生的 C 语言之间的效率差异。通过一点点地深入了解,你一定会发现 Cython 的魅力。

2. 比较一下 Python、C、C 扩展、Cython 之间的差异

作者:古明地觉

公众号:古明地觉的编程教室

公众号二维码:

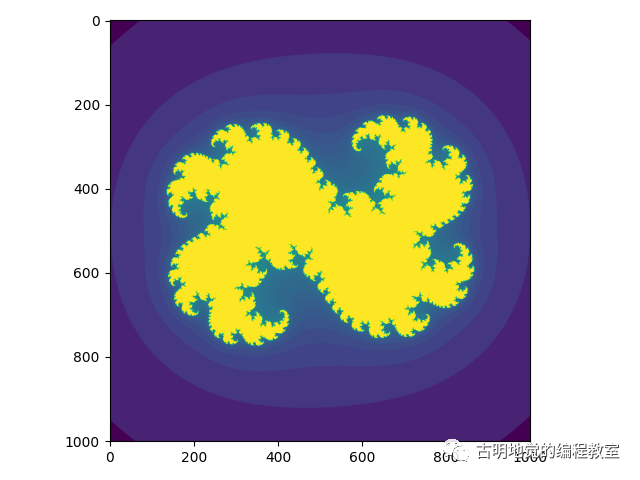

我们以简单的斐波那契数列为例,来测试一下它们执行效率的差异。

Python 代码:

def fib(n):

a, b = 0.0, 1.0

for i in range(n):

a, b = a + b, a

return a

C 代码:

double cfib(int n) {

int i;

double a=0.0, b=1.0, tmp;

for (i=0; i<n; ++i) {

tmp = a; a = a + b; b = tmp;

}

return a;

}

上面便是 C 实现的一个斐波那契数列,可能有人好奇为什么我们使用浮点型,而不是整型呢?答案是 C 的整型是有范围的,所以我们使用 double,而且 Python 的 float 在底层对应的是 PyFloatObject、其内部也是通过 double 来存储的。

C 扩展:

然后是 C 扩展,注意:C 扩展不是我们的重点,写 C 扩展和写 Cython 本质是一样的,都是为 Python 编写扩展模块,但是写 Cython 绝对要比写 C 扩展简单的多。

#include "Python.h"

double cfib(int n) {

int i;

double a=0.0, b=1.0, tmp;

for (i=0; i<n; ++i) {

tmp = a; a = a + b; b = tmp;

}

return a;

}

static PyObject *fib(PyObject *self, PyObject *n) {

if (!PyLong_CheckExact(n)) {

wchar_t *error = L"函数 fib 需要接收一个整数";

PyErr_SetObject(PyExc_ValueError,

PyUnicode_FromWideChar(error, wcslen(error)));

return NULL;

}

double result = cfib(PyLong_AsLong(n));

return PyFloat_FromDouble(result);

}

static PyMethodDef methods[] = {

{"fib",

(PyCFunction) fib,

METH_O,

"这是 fib 函数"},

{NULL, NULL, 0, NULL}

};

static PyModuleDef module = {

PyModuleDef_HEAD_INIT,

"c_extension",

"这是模块 c_extension",

-1,

methods,

NULL, NULL, NULL, NULL

};

PyMODINIT_FUNC PyInit_c_extension(void) {

return PyModule_Create(&module);

}

可以看到,如果是写 C 扩展,即便一个简单的斐波那契,都是非常复杂的事情。

Cython 代码:

最后看看如何使用 Cython 来编写斐波那契,你觉得使用 Cython 编写的代码应该是一个什么样子的呢?

def fib(int n):

cdef int i

cdef double a = 0.0, b = 1.0

for i in range(n):

a, b = a + b, a

return a

怎么样,Cython 代码和 Python 代码是不是很相似呢?虽然我们现在还没有正式学习 Cython 的语法,但你也应该能够猜到上面代码的含义是什么。我们使用 cdef 关键字定义了一个 C 级别的变量,并声明了它们的类型。

Cython 代码也是要编译成扩展模块之后,才能被解释器识别,所以它需要先被翻译成 C 的代码,然后再编译成扩展模块。再次说明,写 C 扩展和写 Cython 本质上没有什么区别,Cython 代码也是要被翻译成 C 代码的。

但很明显,写 Cython 比写 C 扩展要简单很多,如果编写的 Cython 代码质量很高,那么翻译出来的 C 代码的质量同样很高,而且在翻译的过程中还会自动进行最大程度的优化。但如果是手写 C 扩展,那么一切优化都要开发者手动去处理,更何况在功能复杂的时候,写 C 扩展本身就是一件让人头疼的事情。

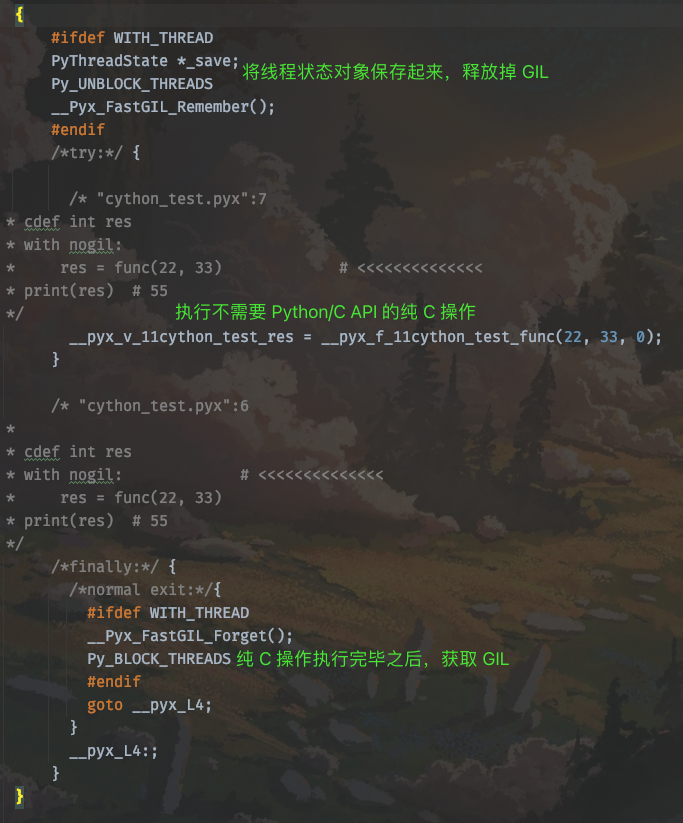

2.1 Cython 为什么能够加速?

观察一下 Cython 代码,和纯 Python 的斐波那契相比,我们看到区别貌似只是事先规定好了变量 i、a、b 的类型而已,关键是为什么这样就可以起到加速的效果呢(虽然还没有测试,但速度肯定会提升的,否则就没必要学 Cython 了)。

但是原因就在这里,因为 Python 中所有的变量都是一个泛型指针 PyObject *,而 PyObject(C 的一个结构体)内部有两个成员。

- ob_refcnt:保存对象的引用计数;

- ob_type:保存对象类型的指针。

不管是整数、浮点数、字符串、元组、字典,亦或是其它的什么,所有指向它们的变量都是一个 PyObject *。当进行操作的时候,首先要通过 -> ob_type 来获取对应类型的指针,再进行转化。

比如 Python 代码中的 a 和 b,我们知道无论进行哪一层循环,结果指向的都是浮点数,但是解释器不会做这种推断。每一次相加都要进行检测,判断到底是什么类型并进行转化;然后执行加法的时候,再去找内部的 __add__ 方法,将两个对象相加,创建一个新的对象;执行结束后再将这个新对象的指针转成 PyObject *,然后返回。

并且 Python 的对象都是在堆上分配空间,再加上 a 和 b 不可变,所以每一次循环都会创建新的对象,并将之前的对象给回收掉。

以上种种都导致了 Python 代码的执行效率不可能高,虽然 Python 也提供了内存池以及相应的缓存机制,但显然还是架不住效率低。

至于 Cython 为什么能加速,我们后面会慢慢聊。

2.2 效率差异

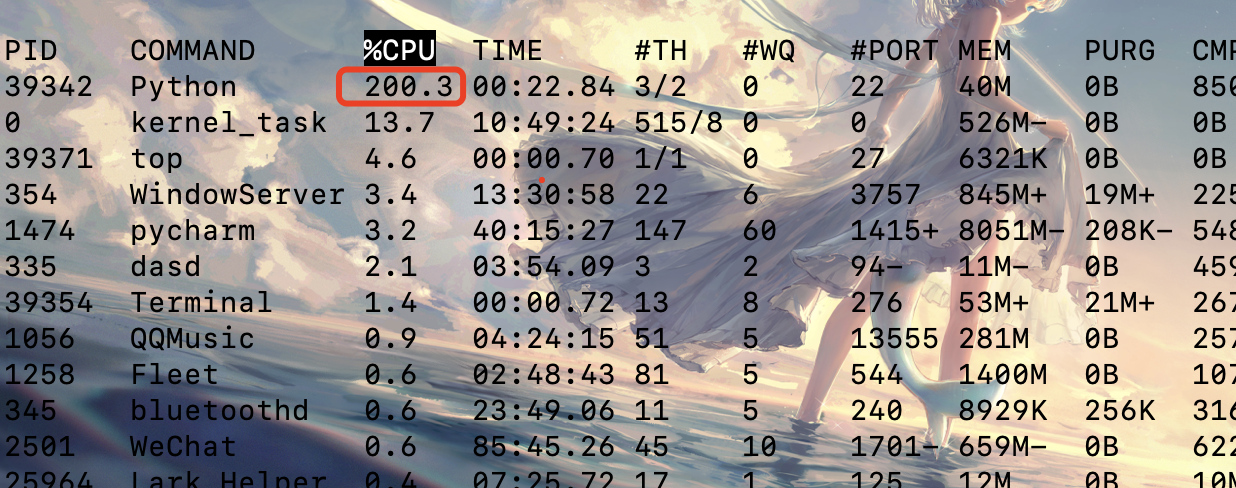

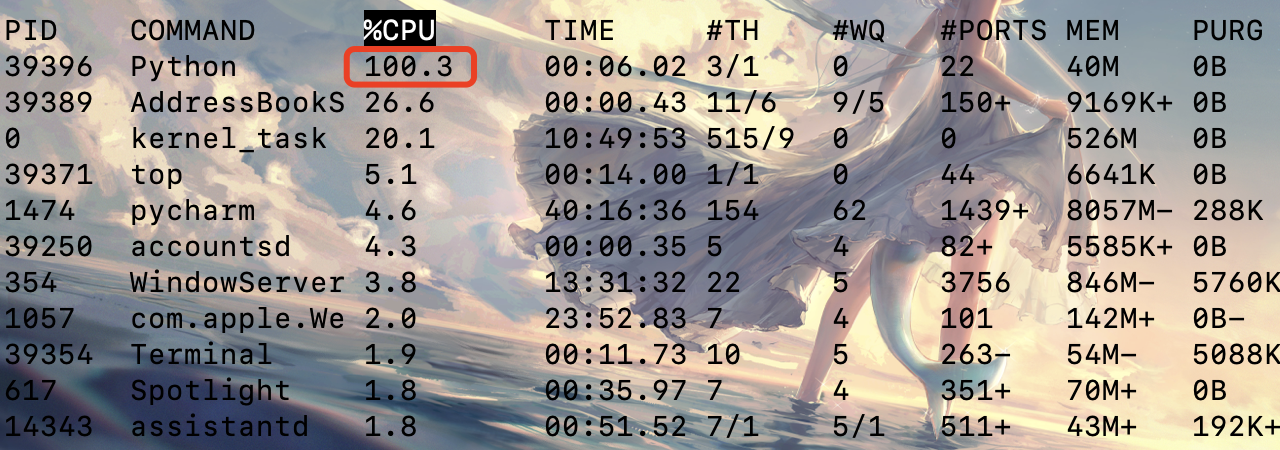

那么它们之间的效率差异是什么样的呢?我们用一个表格来对比一下:

提升的倍数,指的是相对于纯 Python 来说在效率上提升了多少倍。

第二列是 fib(0),显然它没有真正进入循环,fib(0) 测量的是调用一个函数所需要花费的开销。而倒数第二列 "循环体耗时" 指的是执行 fib(90) 的时候,排除函数调用本身的开销,也就是执行内部循环体所花费的时间。

整体来看,纯 C 语言编写的斐波那契,毫无疑问是最快的,但是这里面有很多值得思考的地方,我们来分析一下。

纯 Python

众望所归,各方面都是表现最差的那一个。从 fib(0) 来看,调用一个函数要花 590 纳秒,和 C 相比慢了这么多,原因就在于 Python 调用一个函数的时候需要创建一个栈帧,而这个栈帧是分配在堆上的,而且结束之后还要涉及栈帧的销毁等等。至于 fib(90),显然无需分析了。

纯 C

显然此时没有和 Python 运行时的交互,因此消耗的性能最小。fib(0) 表明了,C 调用一个函数,开销只需要 2 纳秒;fib(90) 则说明执行一个循环,C 比 Python 快了将近80倍。

C 扩展

C 扩展是干什么的上面已经说了,就是使用 C 来为 Python 编写扩展模块。我们看一下循环体耗时,发现 C 扩展和纯 C 是差不多的,区别就是函数调用上花的时间比较多。原因就在于当我们调用扩展模块的函数时,需要先将 Python 的数据转成 C 的数据,然后用 C 函数计算斐波那契数列,计算完了再将 C 的数据转成 Python 的数据。

所以 C 扩展本质也是 C 语言,只不过在编写的时候还需要遵循 CPython 提供的 API 规范,这样就可以将 C 代码编译成 pyd 文件,直接让 Python 来调用。从结果上看,和 Cython 做的事情是一样的。但是还是那句话,用 C 写扩展,本质上还是写 C,而且还要熟悉底层的 Python/C API,难度是比较大的。

Cython

单独看循环体耗时的话,纯 C 、C 扩展、Cython 都是差不多的,但是编写 Cython 显然是最方便的。而我们说 Cython 做的事情和 C 扩展本质是类似的,都是为 Python 提供扩展模块,区别就在于:一个是手动写 C 代码,另一个是编写 Cython 代码、然后再自动翻译成 C 代码。所以对于 Cython 来说,将 Python 的数据转成 C 的数据、进行计算,然后再转成 Python 的数据返回,这一过程也是无可避免的。

但是我们看到 Cython 在函数调用时的耗时相比 C 扩展却要少很多,主要是 Cython 生成的 C 代码是经过高度优化的。不过说实话,函数调用花的时间不需要太关心,内部代码块执行所花的时间才是我们需要注意的。当然啦,如何减少函数调用本身的开销,我们后面也会说。

2.3 Python 的 for 循环为什么这么慢?

通过循环体耗时我们看到,Python 的 for 循环真的是出了名的慢,那么原因是什么呢?来分析一下。

1. Python 的 for 循环机制

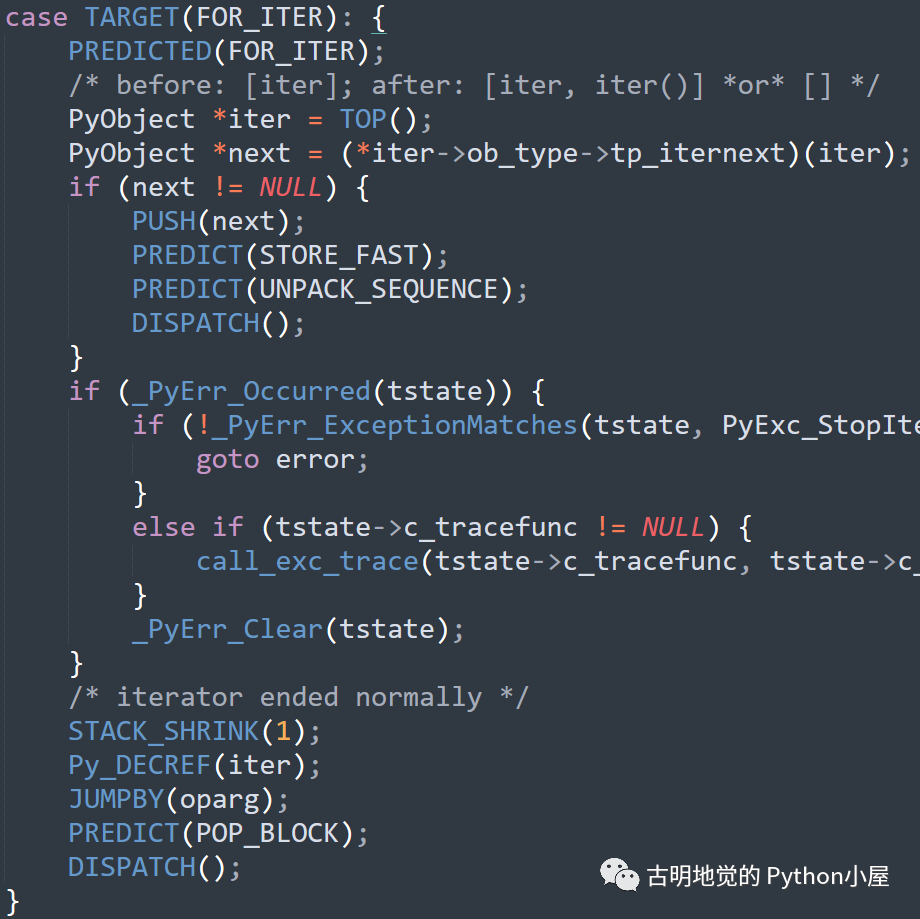

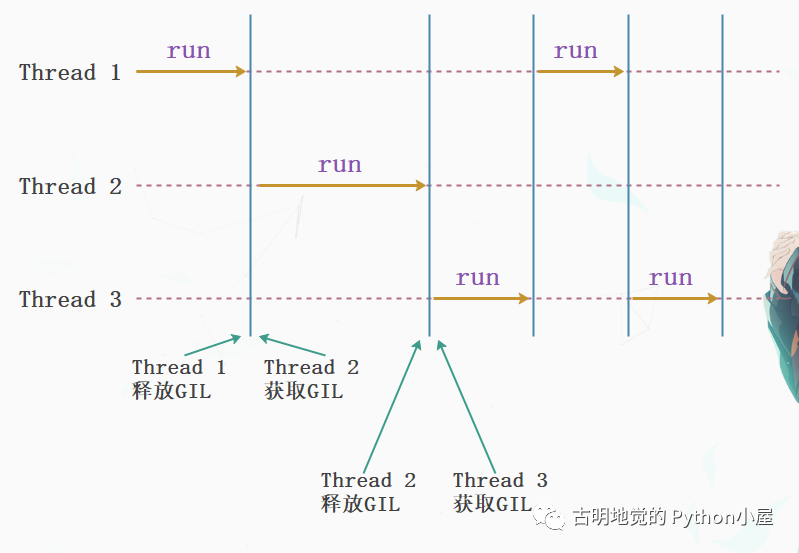

Python 在遍历一个可迭代对象的时候,会先调用可迭代对象内部的 __iter__ 方法得到其对应的迭代器;然后再不断地调用迭代器的 __next__ 方法,将值一个一个的迭代出来,直到迭代器抛出 StopIteration 异常,for 循环捕捉,终止循环。

而迭代器是有状态的,Python 解释器需要时刻记录迭代器的迭代状态。

2. Python 的算数操作

这一点我们上面其实已经提到过了,Python 由于自身的动态特性,使得其无法做任何基于类型的优化。

比如:循环体中的 a + b,这个 a、b 指向的可以是整数、浮点数、字符串、元组、列表,甚至是我们实现了魔法方法 __add__ 的类的实例对象,等等等等。

尽管我们知道是浮点数,但是 Python 不会做这种假设,所以每次执行 a + b 的时候,都会检测其类型到底是什么?然后判断内部是否有 __add__ 方法,有的话则以 a 和 b 为参数进行调用,将 a 和 b 指向的对象相加。计算出结果之后,再将其指针转成 PyObject * 返回。

而对于 C 和 Cython 来说,在创建变量的时候就事先规定了类型为 double,不是其它的,因此编译之后的 a + b 只是一条简单的机器指令。这对比下来,Python 尼玛能不慢吗。

3. Python 对象的内存分配

Python 的对象是分配在堆上面的,因为 Python 对象本质上就是 C 的 malloc 函数为结构体在堆区申请的一块内存。在堆区进行内存的分配和释放需要付出很大的代价,而栈则要小很多,并且它是由操作系统维护的,会自动回收,效率极高,栈上内存的分配和释放只是动一动寄存器而已。

但堆显然没有此待遇,而恰恰 Python 的对象都分配在堆上,尽管 Python 引入了内存池机制使得其在一定程度上避免了和操作系统的频繁交互,并且还引入了小整数对象池、字符串的 intern 机制,以及缓存池等。

但事实上,当涉及到对象(任意对象、包括标量)的创建和销毁时,都会增加动态分配内存、以及 Python 内存子系统的开销。而 float 对象又是不可变的,因此每循环一次都会创建和销毁一次,所以效率依旧是不高的。

而 Cython 分配的变量(当类型是 C 里面的类型时),它们就不再是指针了(Python 的变量都是指针),对于当前的 a 和 b 而言就是分配在栈上的双精度浮点数。而栈上分配的效率远远高于堆,因此非常适合 for 循环,所以效率要比 Python 高很多。另外不光是分配,在寻址的时候,栈也要比堆更高效。

所以在 for 循环方面,C 和 Cython 要比纯 Python 快了几个数量级,这并不是奇怪的事情,因为 Python 每次迭代都要做很多的工作。

2.4 什么时候使用 Cython?

我们看到在 Cython 代码中,只是添加了几个 cdef 就能获得如此大的性能改进,显然这是非常让人振奋的。但是,并非所有的 Python 代码在使用 Cython 编写时,都能获得巨大的性能改进。

我们这里的斐波那契数列示例是刻意的,因为里面的数据是绑定在 CPU 上的,运行时都花费在处理 CPU 寄存器的一些变量上,而不需要进行数据的移动。如果此函数做的是如下工作:

- 内存密集,比如给大数组添加元素;

- I/O 密集,比如从磁盘读取大文件;

- 网络密集,比如从 FTP 服务器下载文件;

那么 Python,C,Cython 之间的差异可能会显著减少(对于存储密集操作),甚至完全消失(对于 I/O 密集或网络密集操作)。

当提升 Python 程序性能是我们的目标时,Pareto 原则对我们帮助很大,即:程序百分之 80 的运行耗时是由百分之 20 的代码引起的。但如果不进行仔细的分析,那么是很难找到这百分之 20 的代码的。因此我们在使用 Cython 提升性能之前,分析整体业务逻辑是第一步。

如果我们通过分析之后,确定程序的瓶颈是由网络 IO 所导致的,那么我们就不能期望 Cython 可以带来显著的性能提升。因此在你使用 Cython 之前,有必要先确定到底是哪种原因导致程序出现了瓶颈。所以尽管 Cython 是一个强大的工具,但前提是它必须应用在正确的道路上。

另外 Cython 将 C 的类型系统引入进了 Python,所以 C 的数据类型的限制也是我们需要关注的。我们知道,Python 的整数不受长度的限制,但 C 的整数是受到限制的,这意味着它们不能正确地表示无限精度的整数。

不过 Cython 的一些特性可以帮助我们捕获这些溢出,总之最重要的是:C 数据类型的速度比 Python 数据类型快,但是会受到限制导致其不够灵活和通用。从这里我们也能看出,在速度以及灵活性、通用性上面,Python 选择了后者。

此外,思考一下 Cython 的另一个特性:连接外部代码。假设起点不是 Python,而是 C/C++,我们希望使用 Python 将多个 C/C++ 模块进行连接。而 Cython 理解 C 和 C++ 的声明,并且它能生成高度优化的代码,因此更适合作为连接的桥梁。

2.5 小结

到目前为止,只是介绍了一下 Cython,并且主要讨论了它的定位,以及和 Python、C 之间的差异。至于如何使用 Cython 加速 Python,如何编写 Cython 代码、以及它的详细语法,我们将后续介绍。

总之,Cython 是一门成熟的语言,它是为 Python 而服务的。Cython 代码不能够直接拿来执行,因为它不符合 Python 的语法规则。

我们使用 Cython 的方式是:先将 Cython 代码翻译成 C 代码,再将 C 代码编译成扩展模块(pyd 文件),然后在 Python 代码中导入它、调用里面的功能方法,这是我们使用 Cython 的正确途径、当然也是唯一的途径。

比如我们上面用 Cython 编写的斐波那契,如果直接执行的话是会报错的,因为 cdef 明显不符合 Python 的语法规则。所以 Cython 代码需要编译成扩展模块,然后在普通的 py 文件中被导入,而这么做的意义就在于可以提升运行速度。因此 Cython 代码应该都是一些 CPU 密集型的代码,不然效率很难得到大幅度提升。

所以在使用 Cython 之前,最好先仔细分析一下业务逻辑,或者暂时先不用 Cython,直接完全使用 Python 编写。编写完成之后开始测试、分析程序的性能,看看有哪些地方耗时比较严重,但同时又是可以通过静态类型的方式进行优化的。找出它们,使用 Cython 进行重写,编译成扩展模块,然后调用扩展模块里面的功能。

那么接下来,我们就来说一说如何编译 Cython 代码。

3. 编译并运行 Cython 代码的几种方式

作者:古明地觉

公众号:古明地觉的编程教室

公众号二维码:

Python 和 C、C++ 之间的一个最重要的差异就是 Python 是解释型语言,而 C、C++ 是编译型语言。如果开发 Python 程序,那么在修改代码之后可以立刻运行,而 C、C++ 则需要一个编译步骤。编译一个规模比较大的 C、C++ 程序,可能会花费几个小时的时间;而使用 Python 则可以让我们进行更敏捷的开发,从而更具有生产效率。

所以在开发游戏的时候,都会引入类似 Lua、Python 之类的脚本语言。特别是手游,脚本语言是必不可少的。

而 Cython 同 C、C++ 类似,在源代码运行之前也需要一个编译的步骤,不过这个编译可以是显式的,也可以是隐式的。如果是显式,那么在使用之前需要提前手动编译好;如果是隐式,那么会在使用的时候自动编译。

而自动编译 Cython 的一个很棒的特性就是它使用起来和纯 Python 是差不多的,但无论是显式还是隐式,我们都可以将 Python 的一部分(计算密集)使用 Cython 重写。因此 Cython 的编译需求可以达到最小化,没有必要将所有的代码都用 Cython 编写,而是将那些需要优化的代码使用 Cython 编写即可。

那么本次就来介绍编译 Cython 代码的几种方式,并结合 Python 使用。因为我们说 Cython 是为 Python 提供扩展模块,最终还是要通过 Python 解释器来调用的。

而编译 Cython 有以下几个选择:

- Cython 代码可以在 IPython 解释器中进行编译,并交互式运行;

- Cython 代码可以在导入的时候自动编译;

- Cython 代码可以通过类似于 Python 内置模块 disutils 的编译工具进行独立编译;

- Cython 代码可以被继承到标准的编译系统,例如:make、CMake、SCons;

这些选择可以让我们在几个特定的场景中应用 Cython,从一端的快速交互式,探索到另一端的快速构建。

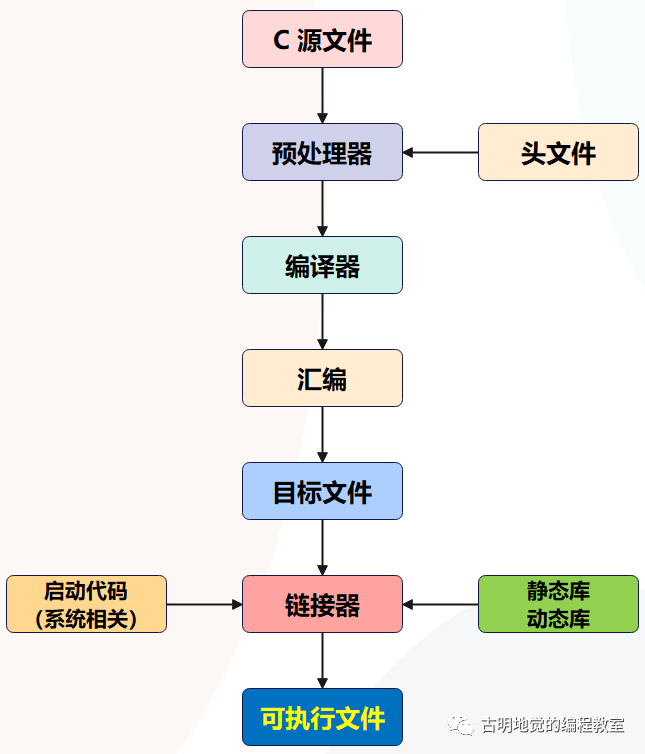

但无论是哪一种编译方式,从 Cython 代码到 Python 可以导入和使用的扩展模块都需要经历两个步骤。在我们讨论每种编译方式的细节之前,需要了解一下这两个步骤到底在做些什么。

3.1 编译步骤

因为 Cython 是 Python 的超集,所以 Python 解释器无法直接运行 Cython 代码,那么如何才能将 Cython 代码变成 Python 解释器可以识别的有效代码呢?

- 1)由 Cython 编译器负责将 Cython 代码转换成经过优化并且依赖当前平台的 C 代码;

- 2)使用标准 C 编译器将第一步得到的 C 代码进行编译并生成标准的扩展模块,并且这个扩展模块是依赖特定平台的。如果是 Linux 或者 Mac OS,那么得到的扩展模块的后缀名为 .so,如果是 Windows ,那么得到的扩展模块的后缀名为 .pyd(本质上是一个 DLL 文件);

不管是什么平台,最终得到的都会是一个成熟的 Python 扩展模块,它是可以直接被 Python 解释器识别并 import 的。

Cython 编译器是一种源到源的编译器,并且生成的扩展模块也是经过高度优化的,因此由 Cython 生成的 C 代码编译得到的扩展模块, 比我们手写的 C 代码编译得到的扩展模块运行的要快,并不是一件稀奇的事情。因为 Cython 生成的 C 代码经过高度精炼,所以大部分情况下比手写所使用的算法更优,而且 Cython 生成的 C 代码支持所有的通用 C 编译器。

所以 Cython 和 C 扩展本质上干的事情是一样的,都是将符合 Python/C API 的 C 代码编译成 Python 扩展模块。只不过写 Cython 的话,我们不需要直接面对 C,Cython 编译器会自动将 Cython 代码翻译成 C 代码,然后我们再将其编译成扩展模块。

因此两者本质是一样的,只不过 C 比较复杂,而且难编程;但是 Cython 简单,语法本来就和 Python 很相似,所以我们选择编写 Cython,然后让 Cython 编译器帮我们把 Cython 代码翻译成 C 的代码。而且重点是得到的 C 代码是经过优化的,如果我们能写出很棒的 Cython 代码,那么也会得到同样高质量的 C 代码。

3.2 安装环境

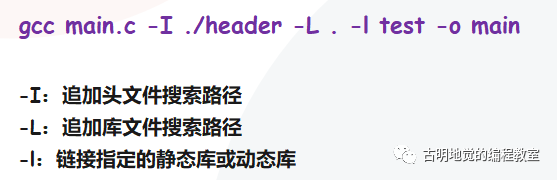

编译 Cython 代码有两个步骤:先将它翻译成 C 代码,然后将 C 代码编译成扩展模块。要实现这两个步骤需要我们确保机器上有 C 编译器以及 Cython 编译器,而不同的平台有不同的选择。

C 编译器

Linux 和 Mac OS 无需多说,因为它们都自带 gcc,但是注意:如果是 Linux 的话,我们还需要安装 python3-devel。安装也很简单,以 CentOS 为例,直接 yum install python3-devel 即可。

至于 Windows,可以下载一个 Visual Studio,但是那个玩意比较大。如果不想下载 VS 的话,那么可以选择安装一个 MinGW 并设置到环境变量中,至于下载方式可以去官网进行下载。

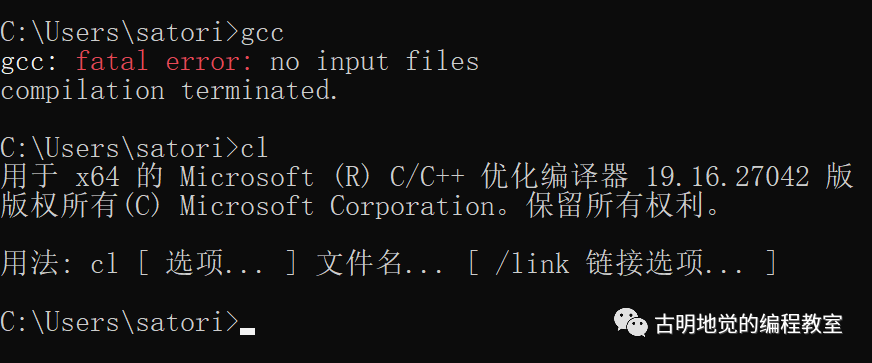

我这里已经配置好了,包括 MinGW 和 Visual Studio。

Cython 编译器

安装 Cython 编译器的话,直接 pip install Cython 即可。因此我们看到 Cython 编译器只是 Python 的一个第三方包,它的作用就是对 Cython 代码进行解析,然后生成 C 代码。因此 Cython 编译器想要运行,同样需要借助 CPython 解释器。

from Cython import __version__

print(__version__) # 0.29.14

如果能够正常执行,那么证明安装成功。

disutils

有了 Cython 编译器,我们就可以生成 C 代码了;有了 C 编译器,我们就能基于 C 代码生成扩展模块了。但是第二步比较麻烦,因为要输入的命令参数非常多,而 Python 有一个标准库 disutils,专门用来构建、打包、分发 Python 工程,可以方便我们编译。

disutils 有一个对我们非常有用的特性,就是它可以借助 C 编译器将 C 源码编译成扩展模块,并且 disutils 是自带的,考虑了平台、架构、Python 版本等因素,因此我们在任意地方使用 disutils 都可以得到扩展模块。

那么废话不多说,下面就来看看如何编译。

3.3 手动编译 Cython 代码

先来编写 Cython 源文件,还以斐波那契数列为例,文件就叫 fib.pyx。Cython 源文件的后缀,以 .pyx 结尾。

def fib(n):

"""这是一个扩展模块"""

cdef int i

cdef double a=0.0, b=1.0

for i in range(n):

a, b = a + b, a

return a

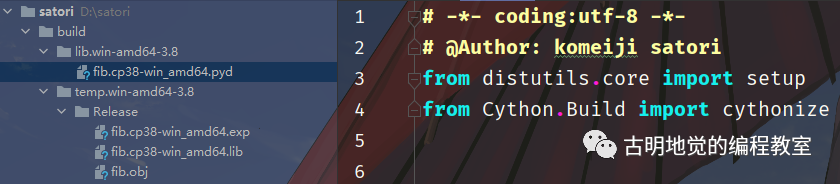

然后我们对其进行编译,首先在当前目录中再创建一个 setup.py,里面写上编译相关的代码:

from distutils.core import setup

from Cython.Build import cythonize

# 我们说构建扩展模块的过程分为两步:

# 1)将 Cython 代码翻译成 C 代码;

# 2)根据 C 代码生成扩展模块

# 第一步要由 Cython 编译器完成, 通过 cythonize;

# 第二步要由 distutils 完成, 通过 distutils.core 下的 setup

setup(ext_modules=cythonize("fib.pyx", language_level=3))

# 里面还有一个参数 language_level=3

# 表示只需要兼容 Python3 即可,而默认是 2 和 3 都兼容

# 如果你是 Python3 环境,那么建议加上这个参数

# cythonize 负责将 Cython 代码转成 C 代码

# 然后 setup 根据 C 代码生成扩展模块

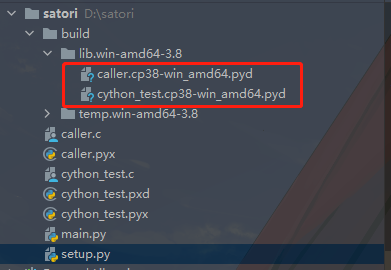

下面就可以进行编译了,通过 python setup.py build 即可完成编译。

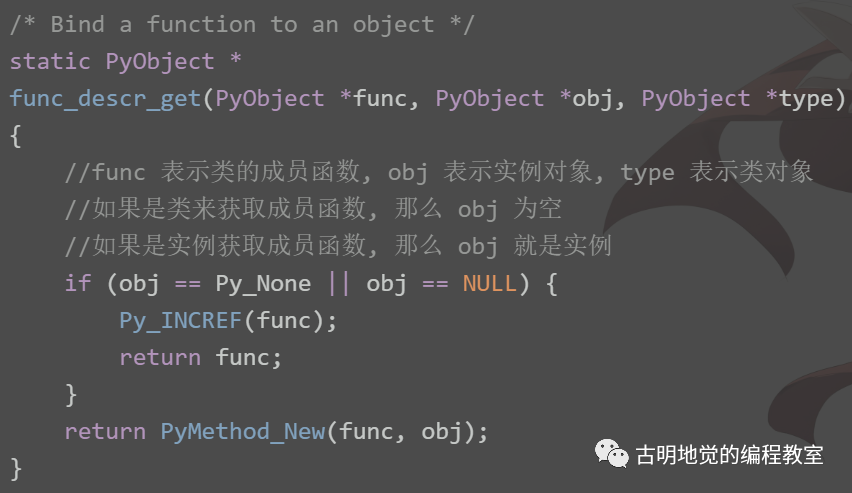

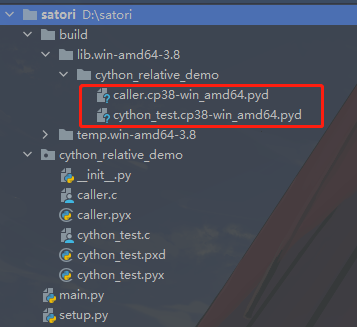

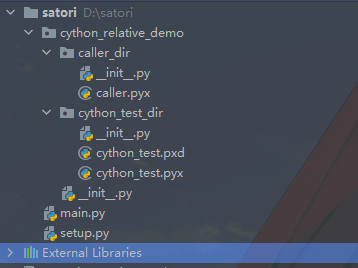

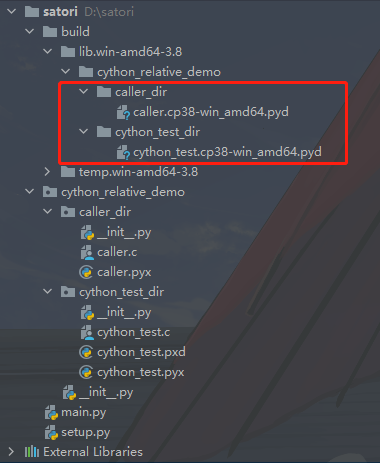

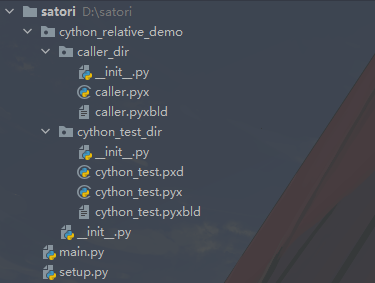

执行完命令之后,当前目录会多出一个 build 目录,里面的结构如图所示。重点是那个 fib.cp38-win_amd64.pyd 文件,该文件就是根据 fib.pyx 生成的扩展模块,至于其它的可以直接删掉了。我们把这个文件单独拿出来测试一下:

import fib

# 我们看到该 pyd 文件直接就被导入了

# 至于中间的 cp38-win_amd64 指的是解释器版本、操作系统等信息

print(fib)

"""

<module 'fib' from 'D:\\satori\\fib.cp38-win_amd64.pyd'>

"""

# 我们在里面定义了一个 fib 函数

# fib.pyx 里面定义的函数在编译成扩展模块之后可以直接用

print(fib.fib(20))

"""

6765.0

"""

# doc string

print(fib.fib.__doc__)

"""

这是一个扩展模块

"""

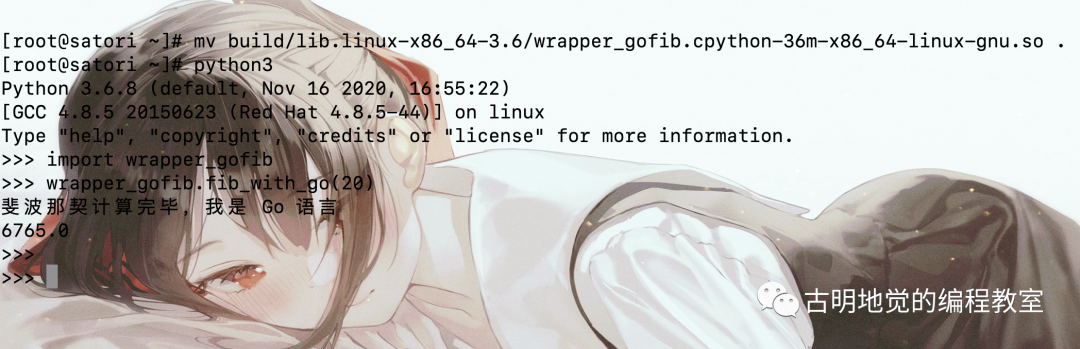

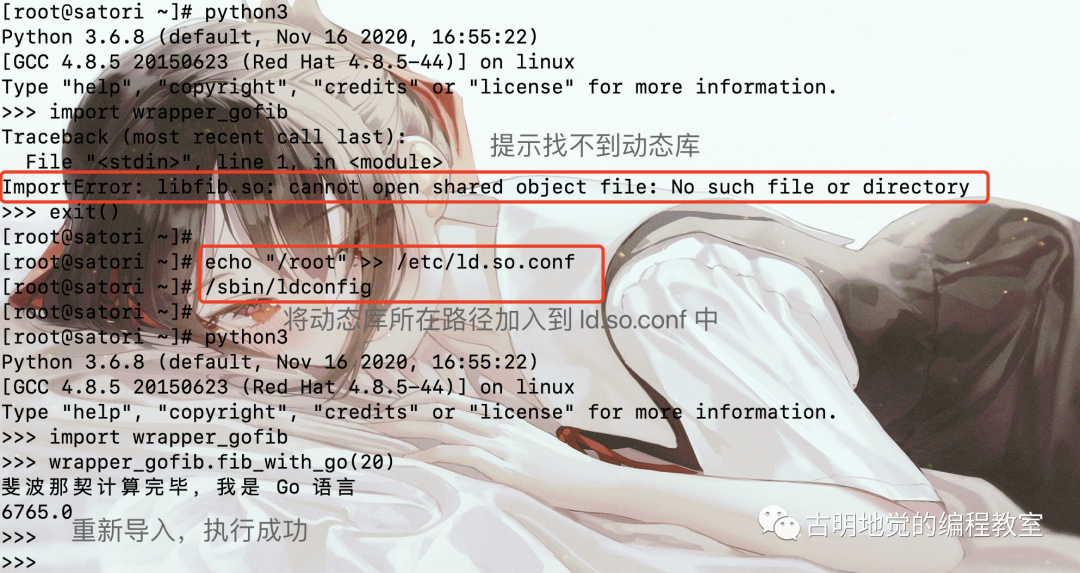

我们在 Linux 上再测试一下,代码以及编译方式都不需要改变,并且生成的扩展模块的位置也不变。

>>> import fib

>>> fib

<module 'fib' from '/root/fib.cpython-36m-x86_64-linux-gnu.so'>

>>> exit()

我们看到依旧是可以导入的,只不过扩展模块在 Linux 上是 .so 的形式,Windows 上是 .pyd。因此我们可以看出,所谓 Python 的扩展模块,本质上就是当前操作系统上一个动态库。只不过生成该动态库的 C 源文件遵循标准的 Python/C API,所以它是可以被解释器识别、直接通过 import 语句导入的,就像导入普通的 py 文件一样。

而对于其它的动态库,比如 Linux 中存在大量的动态库(.so文件),而它们则不是由遵循标准 Python/C API 的 C 文件生成的,所以此时再通过 import 导入,解释器就无法识别了。如果 Python 真的想调用这样的动态库,则需要使用 ctypes、cffi 等模块。

另外在 Windows 环境,编译器可以使用 gcc 或者 vs,那么问题来了,在生成扩展时,要如何指定编译器种类呢?非常简单,可以在标准库 distutils 的目录下新建一个 distutils.cfg 文件,里面写入如下内容:

[build]

compiler=mingw32 或者 msvc

mingw32 代表 gcc,msvc 代表 vs。

然后 Cython 还可以引入 C 源文件,因为 Cython 同时理解 C 和 Python。如果已经有现成的 C 库,那么 Cython 可以直接拿来用。

// 文件名:cfib.h

// 定义一个函数声明

double cfib(int n);

// 文件名:cfib.c

// 函数体的实现

double cfib(int n) {

int i;

double a=0.0, b=1.0, tmp;

for (i=0; i<n; ++i) {

tmp = a; a = a + b; b = tmp;

}

return a;

}

目前已经有 C 实现好的斐波那契函数了,那么在 Cython 里面要如何使用呢?我们来编写 Cython 文件,文件名还是 fib.pyx。

# 通过 cdef extern from 导入头文件

# 写上要用的函数

cdef extern from "cfib.h":

double cfib(int n)

# 然后 Cython 可以直接调用

def fib_with_c(n):

"""调用 C 编写的斐波那契数列"""

return cfib(n)

然后是编译:

from distutils.core import setup, Extension

from Cython.Build import cythonize

"""

之前是直接往 cythonize 里面传入一个文件名即可

但是现在我们传入了一个 Extension 对象

通过 Extension 对象的方式可以实现更多功能

这里指定的 name 表示编译之后的文件名

显然编译之后会得到 wrapper_cfib.cp38-win_amd64.pyd

如果是之前的方式, 那么得到的就是 fib.cp38-win_amd64.pyd

默认会和 .pyx 文件名保持一致, 这里我们可以自己指定

sources 则是代表源文件,需要指定 .pyx 以及使用的 c 源文件

"""

ext = Extension(name="wrapper_cfib",

sources=["fib.pyx", "cfib.c"])

setup(ext_modules=cythonize(ext, language_level=3))

编译之后,进行调用:

import wrapper_cfib

print(wrapper_cfib.fib_with_c(20))

"""

6765.0

"""

print(wrapper_cfib.fib_with_c.__doc__)

"""

调用 C 编写的斐波那契数列

"""

成功调用了 C 编写的斐波那契数列函数,这里我们使用了一种新的创建扩展模块的方法,来总结一下。

- 1)如果是单个 pyx 文件的话,那么直接通过 cythonize("xxx.pyx") 即可。

- 2)如果 pyx 文件还引入了 C 文件,那么 cythonize 里面需要指定一个 Extension 对象。参数 name 是编译之后的扩展模块的名字,参数 sources 是编译的源文件,并且不光要指定 .pyx 文件,依赖的 C 文件同样要指定。

建议后续都使用第二种方式,可定制性更强。

而且我们之前使用的 cythonize("fib.pyx") 完全可以用 cythonize(Extension("fib", ["fib.pyx"])) 进行替代。

关于使用 Cython 包装 C、C++ 代码的更多细节,我们会在后续详细介绍,总之编译的时候相应的源文件是不能少的。

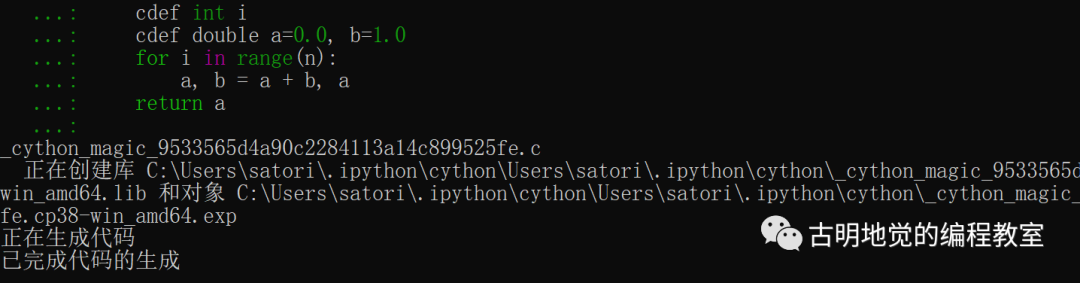

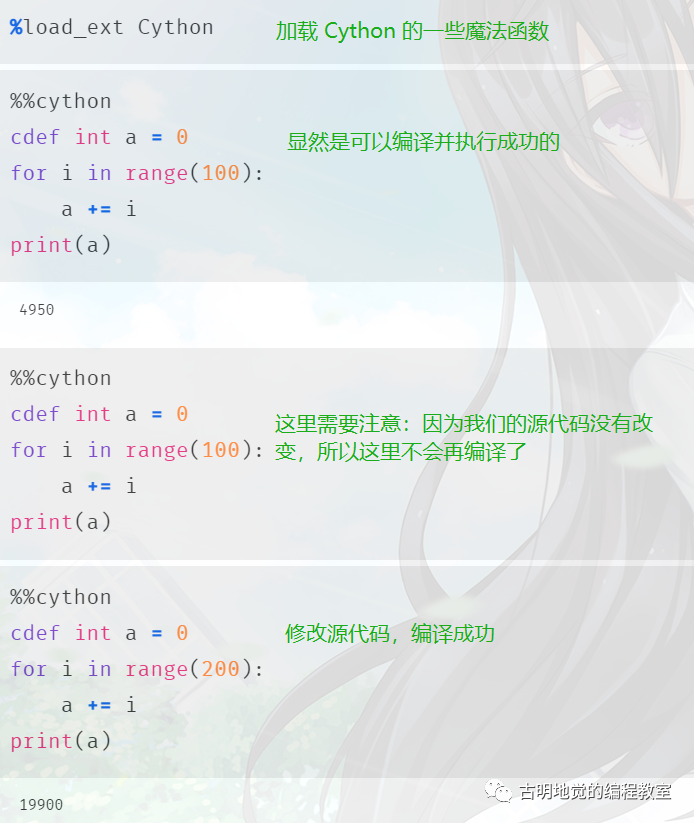

3.4 通过 IPython 动态交互 Cython

使用 distutils 编译 Cython 可以让我们控制每一步的执行过程,但也意味着我们在使用之前必须要先经过独立的编译,不涉及到交互式。而 Python 的一大特性就是交互式,比如 IPython,所以需要想个法子让 Cython 也支持交互式,而实现的办法就是魔法命令。

我们打开 IPython,在上面演示一下。

# 我们在 IPython 上运行

# 执行 %load_ext cython 便会加载 Cython 的一些魔法函数

In [1]: %load_ext cython

# 然后神奇的一幕出现了

# 加上一个魔法命令,就可以直接写Cython代码

In [2]: %%cython

...: def fib(int n):

...: """这是一个 Cython 函数,在 IPython 上编写"""

...: cdef int i

...: cdef double a = 0.0, b = 1.0

...: for i in range(n):

...: a, b = a + b, a

...: return a

# 测试用时,平均花费82.6ns

In [6]: %timeit fib(50)

82.6 ns ± 0.677 ns per loop (mean ± std. dev. of 7 runs, 10000000 loops each)

注意:以上同样涉及到编译成扩展模块的过程。

首先 IPython 中存在一些魔法命令,这些命令以一个或两个百分号开头,它们提供了普通 Python 解释器所不提供的功能。%load_ext cython 会加载 Cython 的一些魔法函数,如果执行成功将不会有任何的输出。

然后重点来了,%%cython 允许我们在 IPython 解释器中直接编写 Cython 代码,当我们按下两次回车时,显然这个代码块就结束了。但是里面的 Cython 代码会被 copy 到名字唯一的 .pyx 文件中,并将其编译成扩展模块,编译成功之后 IPython 会再将该模块里的所有内容都导入到当前环境中,以便我们使用。

因此上述的编译过程、编译完成之后的导入过程,都是我们在按下两次回车键之后自动发生的。但是不管怎么样,它都涉及到编译成扩展模块的过程,包括后面要说的即时编译也是如此,只不过这一步不需要手动做了。

当然相比 IPython,我们更常用 jupyter notbook,既然 Cython 在前者中可以使用,那么后者肯定也是可以的。

jupyter notebook 底层也是使用了 IPython,所以它的原理和 IPython 是等价的,会先将代码块 copy 到名字唯一的 .pyx 文件中,然后进行编译。编译完毕之后再将里面的内容导入进来,而第二次编译的时候由于单元格里面的内容没有变化,所以不再进行编译了。

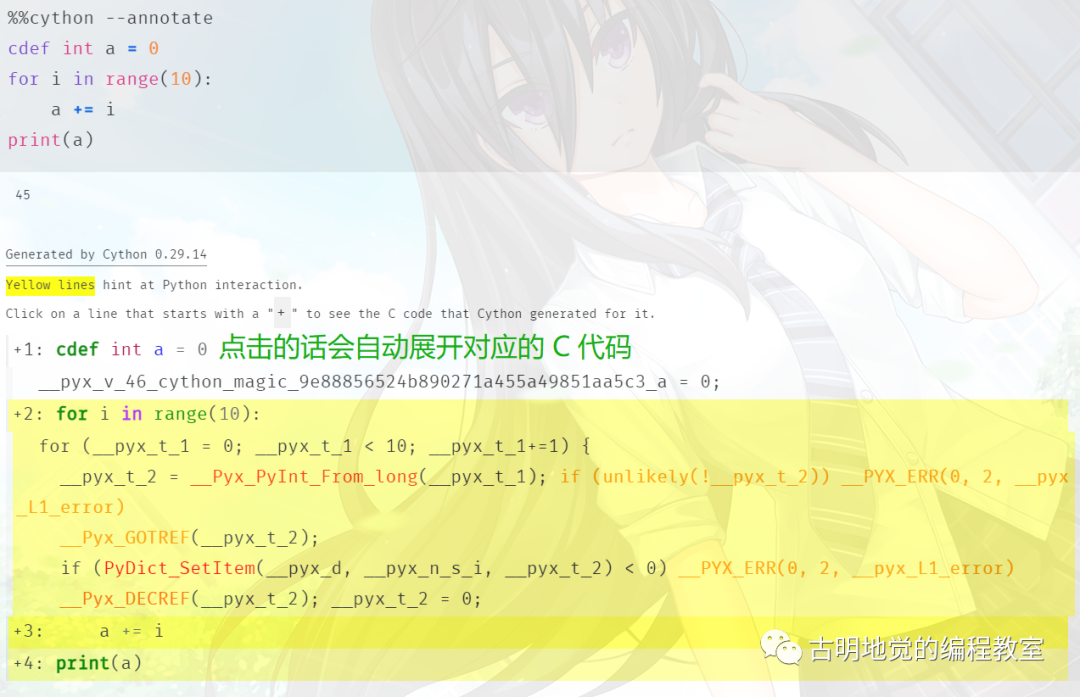

另外在编译的时候如果指定了 --annotate 选项,那么还可以看到对应的代码分析。

可以看到还是非常强大的,尤其是在和 jupyter 结合之后,真的非常方便。

3.5 使用 pyximport 即时编译

因为 Cython 是以 Python 为中心的,所以我们希望 Python 解释器在导包的时候能够自动识别 Cython 文件,导入 Cython 就像导入常规、动态的 Python 文件一样。但是不好意思,Python 在导包的时候并不会自动识别以 .pyx 结尾的文件,但是我们可以通过 pyximport 来改变这一点。

pyximport 也是一个第三方模块,安装 Cython 的时候会自动安装。

def fib(int n):

cdef int i

cdef double a = 0.0, b = 1.0

for i in range(n):

a, b = a + b, a

return a

文件名仍叫 fib.pyx,下面来导入它。

import pyximport

# 这里同样指定 language_level=3

# 表示针对的是 py3

pyximport.install(language_level=3)

# 执行完之后, 解释器在导包的时候就会识别 Cython 文件了

# 当然这个过程也是需要先编译的

import fib

print(fib.fib(20)) # 6765.0

正如我们上面演示的那样,使用 pyximport 可以让我们省去 cythonize 和 distutils 这两个步骤(注意:这两个步骤还是存在的,只是不用我们做了)。

另外 Cython 源文件不会立刻编译,只有当被导入的时候才会编译。即便后续 Cython 源文件被修改了,pyximport 也会自动检测,当重新导入的时候也会再度重新编译,机制就和 Python 的 pyc 文件是一个道理。

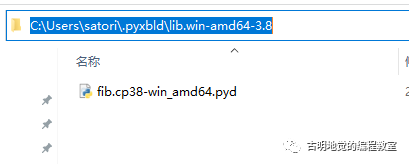

自动编译之后的 pyd 文件位于 ~/.pyxbld/lib.xxx 中。

但是这样有一个弊端,我们说 pyx 文件并不是直接导入的,而是在导入之前先有一个编译成扩展模块的步骤,然后导入的是这个扩展模块,只不过这一步骤不需要我们手动来做了。

所以它要求你的当前环境中有一个 Cython 编译器以及合适的 C 编译器,而这些环境是不受控制的,没准哪天就编译失败了。因此最保险的方式还是使用我们之前说的 distutils,先编译成扩展模块(.pyd 或者 .so),然后再放在生产模式中使用。

但是问题来了,如果 Cython 文件中还引入了其它的 C 文件该怎么办呢?还以我们之前的斐波那契数列为例:

// 文件名:cfib.h

// 定义一个函数声明

double cfib(int n);

// 文件名:cfib.c

// 函数体的实现

double cfib(int n) {

int i;

double a=0.0, b=1.0, tmp;

for (i=0; i<n; ++i) {

tmp = a; a = a + b; b = tmp;

}

return a;

}

然后是 fib.pyx 文件。

cdef extern from "cfib.h":

double cfib(int n)

def fib_with_c(n):

return cfib(n)

那么问题来了,如果这个时候通过 pyximport 来导入 fib 会发生什么后果呢?答案是报错,因为它不知道该去哪里寻找这些外部文件,而显然这些文件应该是要链接在一起的。那么要如何做呢?就是我们下面要说的问题了。

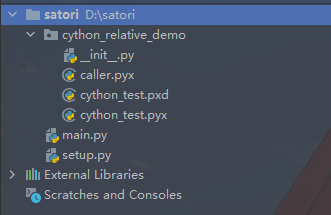

3.6 控制 pyximport 并管理依赖

我们说手动编译的时候,需要指定依赖的 C 文件的位置,但是直接导入 .pyx 文件的时候就不知道这些依赖在哪里了。所以我们应该还要定义一个 .pyxbld 文件,.pyxbld 文件要和 .pyx 文件具有相同的基名称,比如我们是为了指定 fib.pyx 文件的依赖,那么 .pyxbld 文件就应该叫做 fib.pyxbld,并且它们要位于同一目录中。

那么这个 fib.pyxbld 文件里面应该写什么内容呢?

# fib.pyxbld

from distutils.extension import Extension

def make_ext(modname, pyxfilename):

"""

如果 .pyxbld 文件中定义了这个函数

那么在编译之前会进行调用,并自动往进行传参

modname 是编译之后的扩展模块名,显然这里就是 fib

pyxfilename 是编译的 .pyx 文件,显然是 fib.pyx

注意: .pyx 和 .pyxbld 要具有相同的基名称

然后它要返回一个我们之前说的 Extension 对象

:param modname:

:param pyxfilename:

:return:

"""

return Extension(modname,

sources=[pyxfilename, "cfib.c"],

# include_dir 表示在当前目录中寻找头文件

include_dirs=["."])

# 我们看到整体还是类似的逻辑,因为编译这一步是怎么也绕不过去的

# 区别就是手动编译还是自动编译,如果是自动编译,显然限制会比较多

# 想解除限制,则需要定义 .pyxbld 文件

# 但很明显,这和手动编译没啥区别了

此时我们再来直接导入看看,会不会得到正确的结果。

import pyximport

pyximport.install(language_level=3)

import fib

print(fib.fib_with_c(50))

"""

12586269025.0

"""

一切正常。

.pyxbld 文件中除了通过定义 make_ext 函数之外,还可以定义 make_setup_args 函数。对于 make_ext 函数,在编译的时候会自动传递两个参数:modname 和 pyxfilename。但如果定义的是 make_setup_args 函数,那么在编译时不会传递任何参数,一些都由你自己决定。

但这里还有一个问题,首先 Cython 源文件一旦改变了,那么再导入的时候就会重新编译;但如果 Cython 源文件(.pyx)依赖的 C 文件改变了呢?这个时候导入的话还会自动重新编译吗?答案是会的,Cython 编译器不仅会检测 Cython 文件的变化,还会检测它依赖的 C 文件的变化。

我们将 fib.c 中的函数 cfib 的返回值加上 1.1,然后其它条件不变,看看结果如何。

import pyximport

pyximport.install(language_level=3)

import fib

print(fib.fib_with_c(50))

"""

12586269026.1

"""

可以看到结果变了,之前的话还需要定义一个具有相同基名的 .pyxdeps 文件,来指定 .pyx 文件具有哪些依赖,但是目前不需要了,会自动检测依赖文件的变化。

但是说实话,像这种依赖 C 文件的情况,建议还是事先编译好,这样才能百分百稳定运行。当然如果你部署服务的环境具备编译条件,那么也可以不用提前编译。

3.7 小结

目前我们介绍了如何将 pyx 文件编译成扩展模块,对于一个简单的 pyx 文件来说,方法如下:

from distutils.core import setup, Extension

from Cython.Build import cythonize

# 推荐以后就使用这种方法

ext = Extension(

# 生成的扩展模块的名字

name="wrapper_fib",

# 源文件

sources=["fib.pyx", "cfib.c"],

)

setup(ext_modules=cythonize(ext, language_level=3))

如果还依赖 C 文件,那么就在 sources 参数里面把依赖的 C 文件写上即可。另外,如果你在编译时发现报错,找不到相应的头文件、C 源文件,那么说明你的查找目录没有指定正确,而关于这一方面我们后续再聊。

此外还可以通过 pyximport 自动编译,我们后面在学习 Cython 语法的时候,就采用这种自动编译的方式了。因为方便,不需要我们每次都来手动编译,但如果要将服务放在生产环境中,建议还是提前编译好。

4. 探究 Cython 和 Python 的本质差异

作者:古明地觉

公众号:古明地觉的编程教室

公众号二维码:

前面我们说了 Cython 是什么,为什么我们要用它,以及如何编译和运行 Cython 代码。有了这些知识,那么是时候进入 Cython 的深度探索之路了。不过在此之前,我们还是要深入分析一下 Python 和 Cython 的区别。

Python 和 Cython 的差别从大方向上来说无非有两个,一个是:运行时解释和预先编译;另一个是:动态类型和静态类型。

4.1 解释执行和编译执行

为了更好地理解为什么 Cython 可以提高 Python 代码的执行性能,有必要对比一下虚拟机执行 Python 代码和操作系统执行已经编译好的 C 代码之间的差别。

Python 代码在运行之前,会先被编译成 pyc 文件(里面存储的是 PyCodeObject 对象),然后读取里面的 PyCodeObject 对象,创建栈帧,执行内部的字节码。而字节码是能够被 Python 虚拟机解释或者执行的基础指令集,并且虚拟机独立于平台,因此在一个平台生成的字节码可以在任意平台运行。

虚拟机将一个高级字节码翻译成一个或者多个可以被操作系统调度 CPU 执行的低级操作(指令)。这种虚拟化很常见并且十分灵活,可以带来很多好处:其中一个好处就是不会被挑剔的操作系统嫌弃(相较于编译型语言,你在一个平台编译的可执行文件在其它平台上就用不了了),而缺点是运行速度比本地编译好的机器码慢。

站在 C 的角度,由于不存在虚拟机,因此也就不存在所谓的高级字节码。C 代码会被直接编译成机器码,以一个可执行文件或者动态库(.dll 或 .so)的形式存在。但是注意:它依赖于当前的操作系统,是为当前平台和架构量身打造的,可以直接被 CPU 执行,而且级别非常低(伴随着速度快),所以它与所在的操作系统是有关系的。

那么有没有一种办法可以弥补虚拟机的字节码和 CPU 的机器码之间的宏观差异呢?答案是有的,那就是 C 代码可以被编译成一种名为扩展模块的特定类型的动态库,并且这些库可以作为成熟的 Python 模块,但是里面的内容已经是由标准 C 编译器编译成的机器码。Python 虚拟机在导入扩展模块执行的时候,不会再解释高级字节码,而是直接运行机器代码,这样就能移除性能开销。

这里再提一下扩展模块,我们说 Windows 中存在 .dll(动态链接库)、Linux 中存在 .so(共享文件)。如果只是 C 或者 C++、甚至是 Go 等等编写的普通源文件,然后编译成 .dll 或者 .so,那么这两者可以通过 ctypes 调用,但是无法通过 import 导入。如果你强行导入,那么会报错:

ImportError: dynamic module does not define module export function

但如果是遵循 Python/C API 编写,尽管编译出的扩展模块在 Linux 上也是 .so、Windows 上是 .pyd(.pyd 也是个 .dll),但它们是可以直接被解释器识别被导入的。

将一个普通的 Python 代码编译成扩展模块的话(Cython 是 Python 的超集,即使是纯 Python 也可以编译成扩展模块),效率上可以有多大的提升呢?根据 Python 代码所做的事情,这个差异会非常广泛,但是通常将 Python 代码转换成等效的扩展模块的话,效率大概有 10% 到 30% 的提升。因为一般情况下,代码既有 IO 密集也会有 CPU 密集。

所以即便没有任何的 Cython 代码,纯 Python 在编译成扩展模块之后也会有性能的提升。并且如果代码是计算密集型,那么效率会更高。

Cython 给了我们免费加速的便利,让我们在不写 Cython、也就是只写纯 Python 的情况下,还能得到优化。但这种只针对纯 Python 进行的优化显然只是扩展模块的冰山一角,真正的性能改进是使用 Cython 的静态类型来替换 Python 的动态解析。因为 Python 不会进行基于类型的优化,所以即使编译成扩展模块,但如果类型不确定,还是没有办法达到高效率的。

就拿两个变量相加举例:由于 Python 不会做基于类型方面的优化,所以这一行代码对应的机器码的数量显然会很多,即使编译成了扩展模块,其对应的机器码数量也是类似的(内部会有优化,因此机器码数量可能会少一些,但不会少太多)。

这两者区别就是:普通的模块有一个翻译的过程,将字节码翻译成机器码;而扩展模块是事先就已经全部翻译成机器码了。但是 CPU 执行的时候,由于机器码数量是差不多的,因此执行时间也是差不多的,区别就是少了一个翻译的过程。但是很明显,Python 将字节码翻译成机器码花费的时间几乎是不需要考虑的,重点是 CPU 在执行机器码所花费的时间。

因此将纯 Python 代码编译成扩展模块,速度不会提升太明显,提升的 10~30% 也是 Cython 编译器内部的优化,比如发现函数中某个对象在函数结束后就不再使用了,所以将其分配的栈上等等。但如果使用 Cython 时指定了类型,那么由于类型确定,机器码的数量就会大幅度减少。CPU 执行 10 条机器码花的时间和执行 1 条机器码花的时间哪个长,不言而喻。

因此使用 Cython,重点是规定好类型,一旦类型确定,那么速度会快很多。

4.2 动态类型和静态类型

Python 语言和 C、C++ 之间的另一个重要的差异就是:前者是动态语言,后者是静态语言。静态语言要求在编译的时候就必须确定变量的类型,一般通过显式的声明来完成这一点。另一方面,如果一旦声明某个变量,那么之后此作用域中该变量的类型就不可以再改变了。

看起来限制还蛮多的,那么静态类型可以带来什么好处呢?除了编译时的类型检测,编译器也可以根据静态类型生成适应当前平台的高性能机器码。

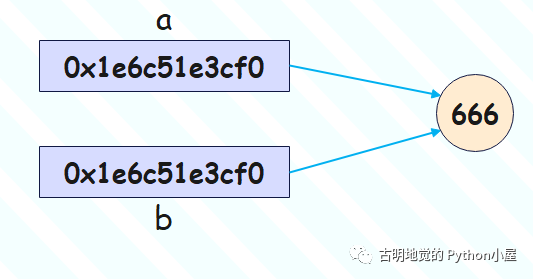

动态语言(针对于 Python)则不一样,对于动态语言来说,类型不是和变量绑定的,而是和对象绑定的,变量只是一个指向对象的指针罢了。因此 Python 中如果想创建一个变量,那么必须在创建的同时赋上值,不然解释器不知道这个变量到底指向哪一个对象。而像 C 这种静态语言,可以创建一个变量的同时不赋上初始值,比如:int n,因为已经知道 n 是一个 int 类型了,所以分配的空间大小也就确定了。

并且对于动态语言来说,变量即使在同一个作用域中,也可以指向任意的对象,因为变量只是一个指针罢了。举个栗子:

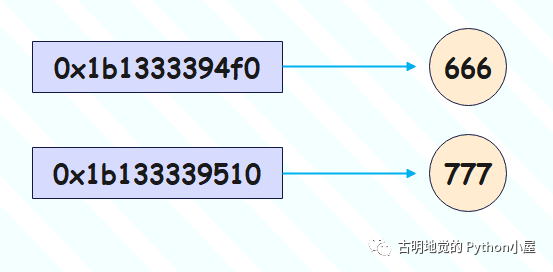

var = 666

var = "古明地觉"

首先是 var = 666,相当于创建了一个整数 666,然后让 var 这个变量指向它;再来一个 var = "古明地觉",那么会创建一个字符串,然后让 var 指向这个字符串。或者说 var 不再存储整数 666 的地址,而是存储新创建的字符串的地址。

所以在运行 Python 程序时,解释器要花费很多时间来确认执行的低阶操作,并抽取相应的数据。不仅如此,考虑到 Python 设计的灵活性,解释器还要以一种非常通用的方式来执行相应的低阶操作,因为 Python 的变量在任意时刻可以指向任意类型的数据。以上便是所谓的动态解析,而 Python 的通用动态解析是缓慢的,还是以 a + b 为栗:

- 1)解释器要检测 a 指向的对象的类型,这在 C 一级至少需要一次指针查找;

- 2)解释器从对应的类型对象中寻找加法的实现,这可能又需要一个或者多个额外的指针查找和内部函数调用;

- 3)如果解释器找到了相应的实现,那么解释器就要发起一个函数调用;

- 4)解释器会调用这个加法函数,并将 a 和 b 作为参数传递进去;

- 5)Python 的对象在 C 中都是一个结构体,比如:整数在 C 中是 PyLongObject,内部有引用计数、类型、ob_size、ob_digit,这些成员是什么不必关心,总之其中一个成员肯定是存放具体的值的,其它成员则是存储额外的属性的。而加法函数显然要从这两个结构体中抽出实际的数据,这需要指针查找以及将数据从 Python 类型转换到 C 类型。如果成功,那么会执行加法操作;如果不成功,比如类型不对,发现 a 是整数但 b 是个字符串,就会报错;

- 6)执行完加法操作之后,必须将结果再转回 Python 对象,因此获取它的指针、转成 PyObject * 之后再返回;

以上就是 Python 执行 a + b 的流程,而 C 语言面对 a + b 这种情况,表现则是不同的。因为 C 是静态编译型语言,C 编译器在编译的时候就决定了执行的低阶操作和要传递的参数数据。

在运行时,一个编译好的 C 程序几乎跳过了 Python 解释器要必须执行的所有步骤。对于 a + b,编译器提前就确定好了类型,比如整型,那么编译器生成的机器码指令是寥寥可数的:将数据加载至寄存器进行相加,然后存储结果。

所以我们看到编译后的 C 程序几乎将时间都只花在了调用快速的 C 函数以及执行等基本操作上,没有 Python 那些花里胡哨的动作。并且由于静态语言对变量类型的限制,编译器会生成更快速、更专业的指令,这些指令是为其数据以及所在平台量身打造的。因此 C 语言比 Python 快上几十倍甚至上百倍,这简直再正常不过了。

而 Cython 在性能上可以带来如此巨大提升的原因就在于,它将 C 的静态类型引入到 Python 中,而静态类型会将运行时的动态解析转化成基于类型优化的机器码。

在 Cython 诞生之前,我们只能通过 C 来实现 Python 代码,然后从静态类型中获益,也就是用 C 编写所谓的扩展模块。但 Cython 的出现则简化了这一点,可以让我们在写类似于 Python 代码的同时,还能使用 C 的静态类型系统。

那么下面我们就来学习 Cython 的第一个、也是最重要的关键字:cdef,它是我们通往 C 性能的大门。

5. 通过 cdef 进行静态类型声明

作者:古明地觉

公众号:古明地觉的编程教室

公众号二维码:

首先 Python 中声明变量的方式在 Cython 里面也是可以使用的,因为 Python 代码也是合法的 Cython 代码。

a = [x for x in range(12)]

b = a

a[3] = 42.0

assert b[3] == 42.0

a = "xxx"

assert isinstance(b, list)

在 Cython 中,没有类型化的动态变量的行为和 Python 完全相同,通过赋值语句 b = a 让 b 和 a 都指向同一个列表。在 a[3] = 42.0 之后,b[3] == 42.0 也是成立的,因此断言成立。

即便后面将 a 修改了,也只是让 a 指向了新的对象,调整相应的引用计数。而对 b 而言则没有受到丝毫影响,因此 b 指向的依旧是一个列表。这是完全合法、并且有效的 Python 代码。

而对于静态类型变量,我们在 Cython 中需要通过 cdef 关键字进行声明,比如:

cdef int i

cdef int j

cdef float k

# 我们看到就像使用 Python 和 C 的混合体一样

j = 0

i = j

k = 12.0

j = 2 * i

assert i != j

上面除了变量的声明之外,其它的使用方式和 Python 并无二致,当然简单的赋值的话,基本上所有语言都是类似的。但是 Python 的一些内置函数、类、关键字等等都是可以直接使用的,因为我们在 Cython 中可以直接写 Python 代码,它是 Python 的超集。

但是有一点需要注意:我们上面创建的变量 i、j、k 是 C 中的类型(int、float 比较特殊,后面会解释),其意义最终要遵循 C 的标准。

不仅如此,就连使用 cdef 声明变量的方式也遵循 C 的标准。

cdef int i, j, k

cdef float x, y

# 声明的同时并赋值

cdef int a = 1, b = 2

cdef float c = 3.0, b = 4.1

而在函数内部,cdef 也是要进行缩进的,它们声明的变量也是一个局部变量。

def foo():

# 这里的 cdef 缩进在函数内部

cdef int i

cdef int N = 2000

# a 没有初始值,默认是零值,即 0.0

cdef float a, b = 2.1

并且 cdef 还可以使用类似于 Python 上下文管理器的方式。

def foo():

# 这种声明方式也是可以的

# 和上面的方式完全等价

cdef:

int i

int N = 2000

float a, b = 2.1

# 但是声明变量时,要注意缩进

# Python 对缩进是有讲究的, 它规定了作用域

# 所以 Cython 在语法方面还是保留了 Python 的风格

所以使用 cdef 声明变量非常简单,格式:cdef 类型 变量名。当然啦,同时也可以赋上初始值。然而一旦使用 cdef 静态声明,那么后续再给变量赋值的时候,就不能那么随心所欲了,举个例子:

# 如果是动态声明,以下都是合法的

# a 可以指向任意的对像,没有限制

a = 123

a = []

# 但如果是静态声明

# 那么 b 的类型必须是整型

cdef int b = 123

# 将一个列表赋值给 a 会出现编译错误

b = [] # compile error

也正是因为在编译阶段就能检测出类型,并分配好内存,所以在执行的时候速度才会快。

5.1 static 和 const

如果你了解 C 的话,那么思考一下:假设要在函数中返回一个局部变量的指针、并且外部在接收这个指针之后,还能访问指针指向的值,这个时候该怎么办呢?我们知道 C 函数中的变量是分配在栈上的(不使用 malloc 函数,而是直接创建一个变量),函数结束之后变量对应的值就被销毁了,所以这个时候即使返回一个指针也是无意义的。

尽管有些时候,在返回指针之后还是能够访问指向的内存,但这只是当前使用的编译器比较笨,在编译时没有检测出来。如果是高级一点的编译器,那么在访问的时候会报出段错误或者打印一个错误的值;而更高级的编译器甚至连指针都不让返回了,因为指针指向的内存已经被回收了,那还要这个指针做什么?因此指针都不让返回了。

而如果想返回指针,那么只需要在声明变量的同时在前面加上 static 关键字,比如 static int i,这样的话 i 这个变量就不会被分配到栈区,而是会被分配到数据区。数据区里变量的生命周期不会随着函数的结束而结束,而是伴随着整个程序。

但可惜的是,static 不是一个有效的 Cython 关键字,因此我们无法在 Cython 中声明一个 C 的 static 变量。

除了 static,在 C 中还有一个 const,用来声明常量。一旦使用 const 声明,比如 const int i = 3,那么这个 i 在后续就不可以被修改了。而在 Cython 中,const 是支持的。

cdef int a = 11

a = 22

print(a)

cdef const int b = 11

b = 22 # 编译错误

print(b)

总之 C 的 static 和 const 目前在 Cython 中无需太关注。

5.2 C 类型

我们上面声明变量的时候,指定的类型是 int 和 float,而在 Python 和 C 里面都有 int 和 float,那么用的到底是谁的呢?其实上面已经说了,用的是 C 的 int 和 float,至于原因,我们后面再聊。

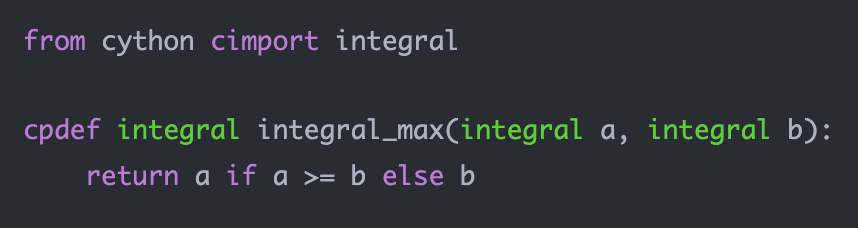

而 Cython 可以使用的 C 类型不仅有 int 和 float,像 short, int, long, unsigned short, long long, size_t, ssize_t, float, double 等基础类型都是支持的,声明变量的方式均为 cdef 类型 变量名。声明的时候可以赋初始值,也可以不赋初始值。

而除了基础类型,还有指针、数组、定义类型别名、结构体、共同体、函数指针等等也是支持的,我们后面细说。

5.3 Cython 的自动类型推断

Cython 还会对函数体中没有进行类型声明的变量自动执行类型推断,比如:for 循环里面全部都是浮点数相加,没有涉及到其它类型的变量,那么 Cython 在自动对变量进行推断的时候会发现这个变量可以被优化为静态类型的 double。

但程序显然无法对动态类型的语言进行非常智能的全方位优化,默认情况下,Cython 只有在确认这么做不会改变代码块的语义之后才会进行类型推断。

看一个简单的函数:

def automatic_inference():

i = 1

d = 2.0

c = 3 + 4j

r = i * d + c

return r

在这个例子中,Cython 会将赋给变量 i、c、r 的值标记为通用的 Python 对象。尽管这些对象的类型和 C 的类型具有高度的相似性,但 Cython 会保守地推断 i 可能无法用 C 的整数表示(C 的整数有范围,而 Python 没有、可以无限大),因此会将其作为符合 Python 代码语义的 Python 对象。

而对于 d = 2.0,则可以自动推断为 C 的 double,因为 Python 的浮点数对应的值在底层就是使用一个 double 来存储的。所以最终对于开发者来讲,变量 d 看似是一个 Python 的对象,但 Cython 在执行的时候会将其视为 C 的 double 以提高性能。

这就是即使我们写纯 Python 代码,Cython 编译器也能进行优化的原因,因为会进行推断。但是很明显,我们不应该让 Cython 编译器去推断,而是明确指定变量的类型。

当然如果非要 Cython 编译器去猜,也是可以的,而且还可以通过 infer_types 编译器指令,在一些可能会改变 Python 代码语义的情况下给 Cython 留有更多的余地来推断一个变量的类型。

cimport cython

@cython.infer_types(True)

def more_inference():

i = 1

d = 2.0

c = 3 + 4j

r = i * d + c

return r

这里出现了一个新的关键字 cimport,它的含义我们以后会说,目前只需要知道它和 import 关键字一样,是用来导入模块的即可。然后我们通过装饰器 @cython.infer_types(True),启动了相应的类型推断,也就是给 Cython 留有更多的猜测空间。

当 Cython 支持更多推断的时候,变量 i 会被类型化为 C 的整型;d 和之前一样是 double,而 c 和 r 都是复数变量,复数则依旧使用 Python 的复数类型。

但是注意:并不代表启用 infer_types 时,就万事大吉了。我们知道在不指定 infer_types 的时候,Cython 推断类型显然是采用最最保险的方法、在保证程序正确执行的情况下进行优化,不能为了优化而导致程序出现错误,显然正确性和效率之间,正确性是第一位的。

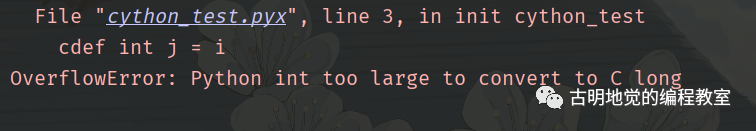

而 C 的整型由于存在溢出的问题,所以 Cython 不会擅自使用。但是我们通过 infer_types 启动了更多的类型推断,让 Cython 在不改变语义的情况下使用 C 的类型。但是溢出的问题它不知道,所以在这种情况下是需要我们来负责确保不会出现溢出。

对于一个函数来说,如果启动这样的类型推断的话,我们可以使用 infer_types 装饰器的方式。不过还是那句话,我们应该手动指定类型,而不是让 Cython 编译器去猜,因为我们是代码的编写者,类型什么的我们自己最清楚。因此 infer_types 这个装饰器,在工作中并不常用,而且想提高速度,就必须事先明确地规定好变量的类型是什么。

5.4 小结

以上就是在 Cython 中如何静态声明一个变量,方法是使用 cdef 关键字。事先规定好类型是非常重要的,一旦类型确定了,那么生成的机器码的数量会少很多,从而实现速度的提升。

而 C 类型的变量的运算速度比 Python 要快很多,这也是为什么 int 和 float 会选择 C 的类型。而除了 int 和 float,C 的其它类型在 Cython 中也是支持的,包括指针、结构体、共同体这样的复杂结构。

但 C 的整型有一个问题,就是它是有范围的,在使用的时候我们要确保不会溢出。所以 Cython 在自动进行类型推断的时候,只要有可能改变语义,就不会擅自使用 C 的整型,哪怕赋的整数非常小。这个时候可以通过 infer_types 装饰器,留给 Cython 更多的猜测空间。

不过还是那句话,我们不应该让 Cython 编译器去猜,是否溢出是由我们来确定的。如果能保证整数不会超过 int 所能表示的最大范围,那么就将变量声明为 int;如果 int 无法表示,那么就使用 long long;如果还无法表示,那就没办法了,只能使用 Python 的整型了。而使用 Python 整型(不光整型,所有类型都是如此)的方式就是不使用 cdef,直接动态声明即可。

所以如果要将变量声明为整型,可以直接使用 ssize_t,等价于 long long。而在工作中,能超过 ssize_t 最大表示范围的整数还是极少的。

# 需要确保赋给 a 的整数,不会超过 ssize_t 所能表示的最大范围

cdef ssize_t a

# b 可能会非常非常大,甚至连 ssize_t 都无法表示

# 此时就需要动态声明了,但很少会遇到这么大的整数

b = ...

另外 ssize_t 我们更喜欢写成 Py_ssize_t,后者是前者的别名。

再次强调,事先规定好类型对速度的提升起着非常重要的作用。因此在声明变量的时候,一定将类型指定好,特别是涉及到数值计算的时候。只不过此时使用的是 C 的类型,需要额外考虑整数溢出的情况,但如果将类型声明为 ssize_t 的话,还是很少会发生溢出的。

以上就是 cdef 的用法,但是还没有结束,我们接下来要介绍更多与类型相关的内容。

6. 支持静态声明的类型

作者:古明地觉

公众号:古明地觉的编程教室

公众号二维码:

上一节我们说了,C 的类型在 Cython 里面都是支持的,下面我们来看一下指针。

cdef double a

cdef double *b = NULL

# 和 C 一样, * 要放在类型或者变量的附近

# 但如果在一行中声明多个指针变量

# 那么每一个变量都要带上 *

cdef double *c, *d

# 如果是下面这样的话

# 则表示声明一个指针变量和一个整型变量

cdef int *e, f

既然可以声明指针变量,那么也能够取得某个变量的地址才对。是的,在 Cython 中通过 & 获取一个变量的地址。

cdef double a = 3.14

cdef double *b = &a

问题来了,既然可以获取指针,那么能不能通过 * 来获取指针指向的值呢?答案是可以获取值,但方式不是通过 * 来实现。Python 的 * 有特殊含义,没错,就是 *args 和 **kwargs,它们允许一个函数接收任意个数的参数,并且通过 * 还可以对一个序列进行解包。

因此对于 Cython 来讲,无法通过 *p 来获取 p 指向的内存。在 Cython 中获取指针指向的内存,可以通过类似于 p[0] 这种方式,p 是一个指针变量,那么 p[0] 就是 p 指向的内存。

cdef double a = 3.14

cdef double *b = &a

print(f"a = {a}")

# 修改 b 指向的内存

b[0] = 6.28

# 再次打印 a

print(f"a = {a}")

该文件叫做 cython_test.pyx,我们在另一个 py 文件中导入它。

import pyximport

pyximport.install(language_level=3)

import cython_test

"""

a = 3.14

a = 6.28

"""

.pyx 文件里面有 print 语句,导入的时候自动打印,而打印结果显示 a 确实被修改了。因此我们在 Cython 中可以通过 & 来获取指针,也可以通过指针[0]的方式获取指针指向的内存。唯一的区别就是 C 里面使用 * 来解引用,而 Cython 里面如果也使用 *,比如 *b = 6.28,那么在语法上是不被允许的。

C 和 Cython 中关于指针还有一个区别,就是指针在指向一个结构体的时候。假设有一个结构体指针叫做 s,里面有两个成员 a 和 b,都是整型。那么对于 C 而言,可以通过 s -> a + s -> b 的方式将两个成员相加;但对于 Cython 来说,则是 s.a + s.b。我们看到这个和 Rust 是类似的,无论是结构体指针还是结构体本身,都是使用 . 的方式访问结构体内部的成员。

6.1 静态类型变量和动态类型变量的混合

Cython 允许静态类型变量和动态类型变量之间进行赋值,这是一个非常强大的特性。它允许我们使用动态的 Python 对象,并且在决定性能的地方能很轻松地将其转化为快速的静态对象。

假设我们有几个静态的 C 整数要组合成一个 Python 的元组,如果使用 Python/C API 创建和初始化的话,会很乏味,需要几十行代码以及大量的错误检查;而在Cython中,只需要像 Python 一样做即可:

cdef int a, b, c

t = (a, b, c)

然后我们来导入一下:

import pyximport

pyximport.install(language_level=3)

import cython_test

# 静态声明的变量如果没有指定初始值

# 那么默认为零值

print(cython_test.t) # (0, 0, 0)

print(type(cython_test.t)) # <class 'tuple'>

print(type(cython_test.t[0])) # <class 'int'>

# 虽然 t 可以访问,但 a、b、c 是无法访问的,因为它们是 C 中的变量

# 使用 cdef 定义的变量都会被屏蔽掉,在 Python 中是无法使用的

try:

print(cython_test.a)

except Exception as e:

print(e) # module 'cython_test' has no attribute 'a'

执行的过程很顺畅,这里要说的是:a、b、c 都是使用 cdef 静态声明的变量,Cython 允许使用它们创建动态类型的 Python 元组,然后将该元组分配给 t。所以这个例子便体现了 Cython 的美丽和强大之处,可以用一种显而易见的方式创建一个元组,而无需考虑其它情况。因为 Cython 的目的就在于此,希望概念上简单的事情在实际操作上也很简单。

想象一下使用 Python/C API 的场景,如果要创建一个元组该怎么办?首先要使用 PyTuple_New 申请指定元素个数的空间,还要考虑申请失败的情况;然后调用 PyTuple_SetItem 将元素一个一个的设置进去,并维护引用计数,这显然是非常麻烦的,肯定没有 t = (a, b, c) 来的直接。

不过话虽如此,但并不是所有东西都可以这么做的。上面的例子之所以有效,是因为 Python 的 int 和 C 的 int(还有 short、long 等等)有明显的对应关系。但如果是指针呢?我们知道 Python 里面没有指针这个概念,或者说指针被隐藏了,只有解释器才能操作指针。因此在 Cython 中,我们不可以在 def 定义的函数里面返回和接收指针,以及打印指针、指针作为 Python 的动态数据结构(如:元组、列表、字典等等)中的某个元素,这些都是不可以的。

回到元组的那个例子,如果 a、b、c 是一个指针,那么必须要在放入元组之前解引用,或者说放入元组中的只能是它们指向的值。因为 Python 在语法层面没有指针的概念,所以不能将指针放在元组里面。

同理:假设 cdef int a = 3,那么可以是 cdef int *b = &a,但绝不能是 b = &a。因为直接 b = ... 的话,那么 b 是 Python 的变量,其类型则需要根据值来推断,然而值是一个指针,所以这是不允许的。

但 cdef int b = a 和 b = a 则都是合法的,因为 a 是一个整数,C 的整数可以转化成 Python 的整数,所以编译的时候会自动转化。只不过前者相当于创建了一个 C 的变量 b,Python 导入的时候无法访问;而后者相当于创建一个 Python 变量 b,Python 导入的时候可以访问。

举个例子:

cdef int a

b = &a

"""

cdef int a

b = &a

^

------------------------------------------------------------

cython_test.pyx:5:4: Cannot convert 'int *' to Python object

Traceback (most recent call last):

"""

我们看到在导入的时候,编译失败了。因为 b 是 Python 的变量,而 &a 是一个 int *,所以无法将 int * 转化成 Python 对象。

再看个例子:

cdef int a = 3

cdef int b = a

c = a

然后导入变量 c 是没问题的,而 a 和 b 则无法导入。

import pyximport

pyximport.install(language_level=3)

import cython_test

try:

print(cython_test.a)

except Exception as e:

print(e) # module 'cython_test' has no attribute 'a'

try:

print(cython_test.b)

except Exception as e:

print(e) # module 'cython_test' has no attribute 'b'

print(cython_test.c) # 3

整数显然是可以赋值的,因为 C 和 Python 都有整数,只不过静态声明的 C 变量,无法被外界访问。

6.2 变量的重名问题

看一下下面的几种情况。

1)先定义一个 C 的变量,然后给这个变量重新赋值:

cdef int a = 3

a = 4

Python 在导入的时候能否访问到 a 呢?答案是访问不到的,虽说是 a = 4 像是创建一个 Python 的变量,但是不好意思,上面已经创建了 C 的变量 a。因此下面再操作 a,都是操作 C 的变量 a,如果来一个 a = "xxx",那么是不合法的。因为 a 已经是整数了,再将一个字符串赋值给 a 显然会报错。

2)先定义一个 Python 变量,再定义一个同名的 C 变量:

b = 3

cdef int b = 4

"""

b = 3

^

------------------------------------------------------------

cython_test.pyx:4:0: Previous declaration is here

"""

即使一个是 Python 的变量,一个是 C 的变量,也依旧不可以重名。不然在 Cython 内部访问 b 的话,究竟访问哪一个变量呢?

所以 b = 3 的时候,变量就已经被定义了,而 cdef int b = 4 又定义了一遍,显然是不合法的。

不光如此,cdef int c = 4 之后再写上 cdef int c = 5 仍然属于重复定义,不合法。但 cdef int c = 4 之后,写上 c = 5 是合法的,因为这相当于改变 c 的值,并没有重复定义。

3)先定义一个 Python 变量,再定义一个同名的 Python 变量:

cdef int a = 666

v = a

print(v)

cdef double b = 3.14

v = b

print(v)

这么做是合法的,其实从 Cython 是 Python 的超集这一点就能理解。主要是:Python 中变量的创建方式和 C 中变量的创建方式是不一样的,Python 的变量只是一个指向某个值的指针,而 C 的变量就是代表值本身。

cdef int a = 5 相当于创建了一个变量 a,这个变量 a 代表的就是 5 本身,只不过这个 5 是 C 的整数 5。而 v = a 相当于先根据 a 的值、也就是 C 的整数 5 创建一个 Python 的整数 5, 然后再让 v 指向它。

那么 v = b 也是同理,因为 v 是 Python 的变量,它想指向谁就指向谁。而 b 是一个 C 的 double,可以转成 Python 的 float。但如果将一个指针赋值给 v 就不可以了,因为 Python 没有任何一个数据类型可以和 C 的指针相对应。

再来看一个栗子:

num = 666

a = num

b = num

print(id(a) == id(b)) # True

首先这个栗子很简单,因为 a 和 b 指向了同一个对象,但如果是下面这种情况呢?

# 这里声明的变量 num 的类型是 long long

# 像 int、long、long long、unsigned int、ssize_t 等等

# 这些类型都表示整型,无非是能表达的整数的范围不同

# 对于 666 这个整数来说,以下的声明方式都行

"""

cdef int num = 666

cdef unsigned long long num = 666

cdef ssize_t num = 666

cdef short num = 666

"""

cdef long long num = 666

a = num

b = num

print(id(a) == id(b))

但当你导入的时候,你会发现打印的是 False,因为此时这个 num 是 C 的变量,然后 a = num 会先根据 num 的值创建一个 Python 的整数,再让 a 指向它;同理 b 也是如此,而显然这会创建两个不同的 666,虽然值一样,但是地址不一样。

如果将 666 改成 123,会发现打印的是 True,原因是 Python 内部存在小整数对象池,池子里面的整数只会创建一次。

所以这就是 Cython 的方便之处,不需要我们自己转化,而是在编译的时候自动转化。当然还是按照我们之前说的,自动转化的前提是可以转化,也就是两者之间要互相对应,比如整数、浮点数。

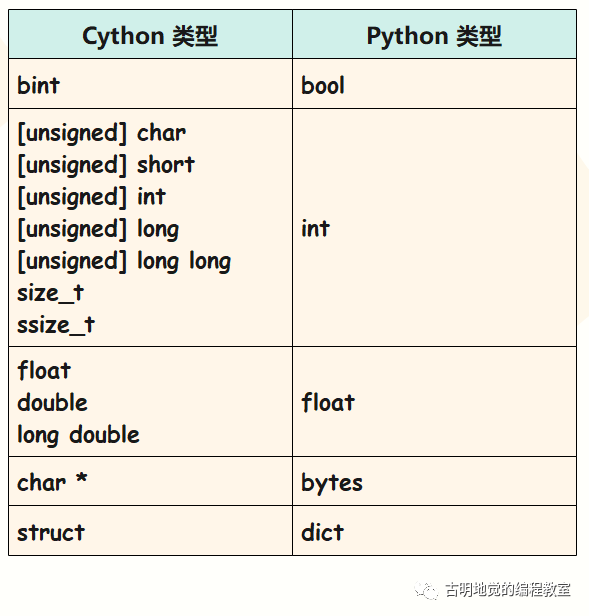

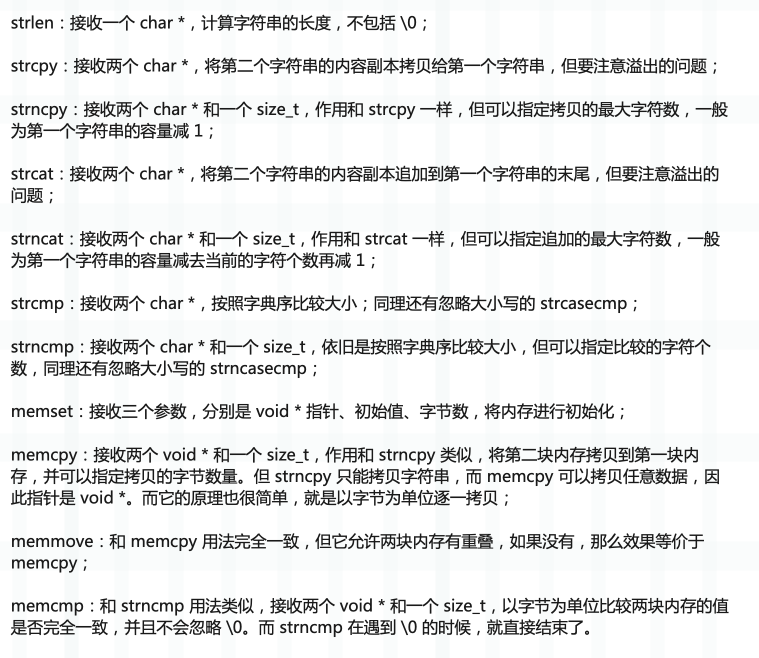

那么 C 类型和 Python 类型之间的对应关系都有哪些呢?我们总结一下:

注意:C 的布尔类型在 Cython 里面叫做 bint,0 为假,非 0 为真。

这里再多说一句整数溢出的情况,举个例子:

# 显然 C 的 int 是存不下的

i = 2 << 81

# 此处会溢出

cdef int j = i

执行一下看看:

我们看到转成 C 的 int 时,如果存不下会自动尝试使用 long。若还存不下,则报错。

6.3 使用 Python 类型进行静态声明

使用 cdef 声明变量属于静态声明,这种方式声明的变量只能在 Cython 内部使用,Python 是无法访问的;而不使用 cdef、也就是直接创建一个变量,属于动态声明,这种方式声明的变量 Python 可以访问。

然后使用 cdef 声明变量的时候,我们给变量指定类型可以提升效率,但到目前为止我们用的都是 C 的类型,那么 Python 的类型可不可以呢?显然是可以的。

只要是在 CPython 中实现了,并且 Cython 有权限访问的话,都可以用来进行静态声明,而 Python 的内建类型都是满足要求的。换句话说,只要在 Python 中可以直接拿来用的,都可以直接当成 C 的类型来进行声明(bool 类型除外,bool 的话使用 bint)。

# 声明的时候直接初始化

cdef tuple b = tuple("123")

cdef list c = list("123")

cdef dict d = {"name": "古明地觉"}

cdef set e = {"古明地觉", "古明地恋"}

cdef frozenset f = frozenset(["古明地觉", "古明地恋"])

A = a

B = b

C = c

D = d

E = e

F = f

我们测试一下:

import pyximport

pyximport.install(language_level=3)

from cython_test import *

print(A) # 古明地觉

print(B) # ('1', '2', '3')

print(C) # ['1', '2', '3']

print(D) # {'name': '古明地觉'}

print(E) # {'古明地恋', '古明地觉'}

print(F) # frozenset({'古明地恋', '古明地觉'})

得到的结果是正确的,完全可以使用 Python 的类型静态声明。并且声明的时候,我们都赋上了一个初始值,但如果只是声明没有赋上初始值,那么默认为 None。

注意:只要是用 Python 的类型进行静态声明且不赋初始值,那么结果都是 None。比如:cdef tuple b; B = b,那么 Python 在打印 B 的时候显示的就是 None,而不是一个空元组。不过整型是个例外,因为 int 我们实际上用的是 C 里面 int,会得到一个 0,当然还有 float。

问题来了,为什么 Cython 可以做到这一点呢?实际上这些结构在 CPython 中都是已经实现好了的,Cython 只需将变量设置为指向底层某个数据结构的 C 指针。比如 cdef tuple a,那么 a 就是一个 PyTupleObject *,它们可以像普通变量一样使用。

6.4 用于加速的静态类型

我们上面介绍了在 Cython 中使用 Python 的类型进行静态声明,这咋一看有点古怪,为什么不直接使用 Python 的方式创建变量呢?

比如 a = [1, 2, 3] 不香么?为什么非要使用 cdef list a = [1, 2, 3] 这种形式呢?答案是为了遵循一个通用的 Cython 原则:我们提供的静态信息越多,Cython 就越能优化结果。

因为 a = [1, 2, 3],这个 a 可以指向任意的对象,但是 cdef list a = [1, 2, 3] 的话,这个 a 只能指向列表。

cdef list a = [1, 2, 3]

# 合法

a = [2, 3, 4]

# 不合法,因为 a 只能指向列表

a = (2, 3, 4)

在使用 cdef 声明时,如果变量的类型是 C 的类型,那么变量代表值;如果变量的类型是 Python 的类型,那么变量仍是指向值的指针,只不过指针的类型确定了。

比如通过 cdef list a 声明的变量 a 仍是一个指针,但它不再是泛型指针 PyObject *,而是 PyListObject *,在明确了类型的时候,执行的速度会更快。我们举个例子:

a = []

a.append(1)

我们只看 a.append(1) 这一行,显然它再简单不过了,但你知道解释器是怎么操作的吗?

- 1)检测类型,Python 的变量是一个 PyObject *,因为任何对象在底层都嵌套了 PyObject 这个结构体,但具体是什么类型则需要进一步检索才知道。通过 ob_type 成员,拿到其类型。

- 2)判断类型对象内部是否有 append 方法,有的话则获取,这又需要一次查找。

- 3)进行调用。

因此我们看到一个简单的 append,Python 内部是需要执行以上几个步骤的,但如果我们事先规定好了类型呢?

cdef list a = []

a.append(1)

对于动态变量而言,解释器事先并不知道它指向哪种类型的对象,只能运行时动态转化。但如果创建的时候指定了类型为 list,那么此时的 a 不再是 PyObject *,而是 PyListObject *,解释器知道 a 指向了一个列表。

而我们对列表进行 append 的时候,底层会调用的 C 一级的函数 PyList_Append,索引赋值调用的是 PyList_SetItem,索引取值调用的是 PyList_GetItem,等等等等。每一个操作在 C 一级都指向了一个具体的函数,如果提前知道了类型,那么 Cython 生成的代码可以将上面的三步变成一步。

没错,既然知道指向的是列表了,那么 a.append(1) 会直接调用 PyList_Append 这个 C 一级的函数,这样省去了类型检测、属性查找等步骤,直接调用即可。

所以列表解析比普通的 for 循环快也是如此,因为 Python 对内置结构非常熟悉,当我们使用的是列表解析式,那么解释器就知道要创建一个列表了,因此同样会直接使用 PyList_Append 这个 C 一级的函数。而如果是普通的 for 循环加上 append,那么解释器就要花费很多时间在类型转化和属性查找上面,需要先兜兜转转经过几次查找,然后才能找到 PyList_Append。

但需要注意的是,上面的变量 a 虽然是 list 类型,但它是使用 cdef 静态声明的变量,所以依旧不能被 Python 访问,只能在 Cython 内部使用。可能有人好奇这是为什么,下面来解释一下。

我们知道 Python 的变量存储在名字空间里面,名字空间是一个字典,但字典在底层是用 C 的数组实现的。而 C 的数组要求里面的元素类型必须一致,所以这也是为什么 Python 的变量都是泛型指针 PyObject *。因为指向不同对象的指针,类型是不同的,但指针可以互相转化,因此它们都要转成同一种类型的指针之后,才能放到名字空间里面,而这个指针就是泛型指针 PyObject *。

PyObject 是对象的基石,它里面保存了对象的引用计数(ob_refcnt)和类型(ob_type),任何一个对象,内部都嵌套了 PyObject。所以无论什么对象,它的指针都必须转成 PyObject * 之后才能交给变量保存,然后通过变量操作的时候,也要先根据 ob_type 判断对象的类型,然后再去寻找相关操作。

但我们上面的是静态列表,使用 cdef 声明变量 a 的时候指定了 list,那么 a 就是PyListObject *。所以解释器在操作变量 a 的时候,知道它指向一个列表,因此就省去了类型判断相关的步骤,得到性能的提升。但与此相对的,由于它不是 PyObject *,所以无法放在名字空间中,自然也无法被 Python 访问了。

如果是动态声明的列表,那么 PyListObject * 会转成 PyObject *,然后交给变量保存,此时会放到名字空间中,让 Python 能够访问。但很明显,在具体操作的时候,速度就不那么快了。

同理我们在 Cython 中使用 for 循环的时候,也是如此。如果我们循环一个可迭代对象,而这个可迭代对象内部的元素都是同一种类型(假设是 dict 对象),那么在循环之前可以先声明循环变量的类型。比如:cdef dict item,然后再 for item in iterator,这样也能提高效率。

总之 Python 慢的原因就是无法基于类型进行优化, 以及对象都申请在堆区。所以我们使用 Cython 的时候,一定要规定好类型,通过 cdef 引入静态类型系统,来保证执行的效率。但这么做的缺点就是一旦规定好类型(无论是 C 的类型还是 Python 的类型),后续就不能再改变了,不过动态性和程序的运行效率本身就是无法兼得的。

而提升效率的另一个手段就是不要把对象放在堆区申请,换句话说如果能用 C 的类型,就不要用 Python 的类型。但很明显,我们不可能不用 Python 的类型,像整型、浮点型还好,而其它复杂的 Python 类型该用还是要用的。

总之,使用 Cython 的重点是做好类型标注。

6.5 Python 类型不可以使用指针

这里还需要强调一下,使用 Python 的类型声明变量的时候不可以使用指针的形式,比如:cdef tuple *t,这么做是不合法的,会报错:

Pointer base type cannot be a Python object

此外,我们使用 cdef 的时候指定了类型,那么赋值的时候就不可以那么无拘无束了。比如:cdef tuple a = list("123") 就是不合法的,因为声明了 a 指向一个元组,但是我们给了一个列表,那么编译扩展模块的时候就会报错:TypeError: Expected tuple, got list。

这里再思考一个问题,我们说 Cython 中使用 cdef 创建的变量无法被直接访问,需要将其赋值给 Python 中的变量才可以使用。那么,在赋完值的时候,这两个变量指向的是同一个对象吗?

cdef list a = list("123")

# a 是一个 PyListObject *, 但 b 是一个 PyObject *

# 那么这两位老铁是不是指向同一个 PyListObject 对象呢?

b = a

# 打印一下 a is b

print(a is b)

# 修改 a 的第一个元素之后,再次打印b

a[0] = "xxx"

print(b)

我们测试一下:

import pyximport

pyximport.install(language_level=3)

import cython_test

"""

True

['xxx', '2', '3']

"""

我们看到 a 和 b 确实指向同一个对象,并且 a 在本地修改了之后,会影响到 b。因为 b = a 本质上就是将 PyListObject * 转成了 PyObject *,然后交给变量 b。很明显,虽然指针类型不一样,但存储的地址是一样的。

两个变量指向的是同一个列表、或者 PyListObject 结构体实例,所以操作任何一个变量都会影响另一个。只不过变量 a 操作的时候会快一些,而变量 b 操作的时候会做一些额外的工作。

6.6 小结

Cython 将 C 的类型引入到了 Python 中,通过 cdef 声明变量时规定好类型,可以极大地减少 CPU 执行的机器码数量。并且 C 的数据默认是分配在栈上面的,执行的时候会更快。当然啦,Cython 同时理解 C 和 Python,所以 Cython 里面不仅可以使用 C 的类型,还可以使用 Python 的内置类型。

如果使用 Python 的类型静态声明,那么对象仍会分配在堆上,只是返回的指针不再是泛型指针,而是某个具体对象的指针。这样可以避免类型检测等开销,依旧能实现效率的提升。

要是你觉得效率提升的还不够,那么在 Cython 里面还可以将列表替换成 C 数组,将字典替换成 C 结构体,进一步实现效率的提升。但很明显,此时就不像是写 Python 了。当用到 C 数组、结构体等复杂结构时,一般都是为了调用已存在的 C 库函数,比如某个 C 库函数需要接收一个结构体。

所以在不涉及已有的 C 库时,C 的数据结构我们只使用整数、浮点数即可(默认行为)。如果列表、集合、字典之类的复杂数据结构也想办法用 C 的数据结构代替的话,那我觉得还不如直接用 C++ 或者 Rust。

关于 C 数组、结构体相关的内容后面会介绍,而要不要在你的项目中使用它们就看你自己了。总之使用 Python 开发程序,能够轻松地获得开发效率,因为 Python 灵活且动态,但与此同时也要忍受运行时的低效率。

虽然通过引入 Cython,可以轻松地将程序的性能从 60 分提高到 90 分。但 Cython 毕竟是为 Python 服务的,所以想从 90 分再往上提高就非常困难了,代码也会变得更加复杂。如果真的追求极致的性能,那么最佳做法是换一门更有效率的静态语言,因为 Python 程序不管怎么优化,也不可能真的媲美 C++ 和 Rust 之类的静态语言。

7. 静态整型和静态字符串类型

作者:古明地觉

公众号:古明地觉的编程教室

公众号二维码:

7.1 静态整型

Cython 的变量和 Python 的变量是等价的,只不过前者是静态的,后者是动态的,而动态变量可以使用的 API,静态变量都可以使用。只不过对于 int 和 float 来说,C 里面也存在同名的类型,而且会默认使用 C 的类型,这也是我们期望的结果。

而一旦使用的是 C 里面的 int 和 float,比如 cdef int a = 1, cdef float b = 22.33,那么 a 和 b 就不再是指针了,它们代表的就是 C 的整数和浮点数。

那为什么在使用 int 和 float 的时候,要选择 C 的 int 和 float 呢?答案很好理解,因为 Cython 本身就是用来加速计算的,而提到计算,显然避不开整数和浮点数,因此 int 和 float 默认使用 C 里面的类型。

事实上单就 Python 的整数和浮点数来说,在运算时底层也是先转化成 C 的类型,然后再操作,最后将操作完的结果再转回 Python 的类型。而如果默认使用 C 的类型,就少了转换这一步,可以极大地提高效率。但我们要知道 C 的整型是有范围的,我们在使用的时候要确保数值的大小不会溢出,这一点前面已经说过了。但是除此之外,还有一个重要的区别,就是除法和取模,在除法和取模上,C 的整型使用的却不是 C 的标准。

当使用有符号整数计算模的时候,C 和 Python 有着明显不同的行为:比如 -7 % 5,如果是 Python 的话那么结果为 3,C 的话结果为 -2。显然 C 的结果是符合我们正常人思维的,但是为什么 Python 得到的结果这么怪异呢?

事实上不光是 C,Go、Js 也是如此,计算 -7 % 5 的结果都是 -2,但 Python 得到 3,原因就是因为其内部的机制不同。我们知道 a % b,等于 a - (a / b) * b,其中 a / b 表示两者的商。比如 7 % 2,等于 7 - (7 / 2) * 2 = 7 - 3 * 2 = 1,对于正数,显然以上所有语言计算的结果都是一样的。

而负数出现差异的原因就在于:C 在计算 a / b 的时候是截断小数点,而 Python 是向下取整。比如上面的 -7 % 5,等于 -7 - (-7 / 5) * 5。-7 / 5 得到的结果是负的一点多,C 的话直接截断得到 -1,因此结果是 -7 - (-1) * 5 = -2;但 Python 是向下取整,负的一点多变成 -2,因此结果变成了 -7 - (-2) * 5 = 3。

# Python 的 / 默认是得到浮点数

# 整除的话使用 //

# 我们看到得到的是 -2

print(-7 // 5) # -2

因此在除法和取模方面,尤其需要注意。另外即使在 Cython 中,也是一样的。

cdef int a = -7

cdef int b = 5

cdef int c1 = a / b

cdef int c2 = a // b

print(c1) # -2

print(c2) # -2

print(-7 // 5) # -2

以上打印的结果都是 -2,说明 Cython 默认使用 Python 的语义执行除法操作,当然还有取模,即使操作的对象是静态类型的 C 标量。这么做的原因就在于为了在最大程度上和 Python 保持一致,如果想要启动 C 语义都需要显式地进行开启。

然后我们看到 a 和 b 是静态类型的 C 变量,它们也是可以使用 // 的,因为 Cython 的目的就像写 Python 一样。但无论是 c1 还是 c2,打印的结果都是 -2,这很好理解。

首先 c1 和 c2 都是静态的 int,在赋值的时候会将浮点数变成整数,至于是直接截断还是向下取整则是和 Python 保持一致,是按照 Python 的标准来的。而 a / b 得到的是 -1.4,在赋值给 int 类型的 c1 时会向下取整。至于 a // b 就更不用说了,a // b 本身就表示整除,因此 c2 也是 -2。然后我们再来举个浮点数的例子。

cdef float a = -7.

cdef float b = 5.

cdef float c1 = a / b

cdef float c2 = a // b

print(c1) # -1.399999976158142

print(c2) # -2.0

a / b 是 -1.4,但此时的 c1 是浮点数,所以没有必要取整了,小数位会保留;而 a // b虽然得到的也是浮点(只要 a 和 b 中有一个是浮点,那么 a / b 和 a // b 得到的也是浮点),但它依旧具备整除的意义,所以 a // b 得到结果是 -2.0,然后赋值给一个 float 变量,还是 -2.0。

关于 Python 中 / 和 // 在不同操作数之间的差异,我们再举个栗子看一下:

# 3.5, 很好理解

7 / 2 == 3.5

# // 表示整除,因此 3.5 会向下取整, 得到 3

7 // 2 == 3

# -3.5,很好理解

-7 / 2 == -3.5

# // 表示取整,因此 -3.5 会向下取整,得到 -4

-7 // 2 == -4

# 3.5, 依旧没问题

7.0 / 2 == 3.5

# // 两边出现了浮点,结果也是浮点,但 // 又代表整除

# 所以你可以简单认为是先取整(得到 3), 然后变成浮点(得到3.0)

7.0 // 2 == 3.0

# -3.5,依旧很简单

-7.0 / 2 == -3.5

# -3.5 和 -3.9 都会向下取整,然后得到-4

# 但结果是浮点,所以是-4.0

-7.0 // 2 == -7.8 // 2 == -4.0

# 3.5,没问题

-7.0 / -2 == 3.5

# 3.5 向下取整,得到3

-7.0 // -2 == 3

所以 Python 的整除或者说地板除还是比较奇葩的,主要原因就在于其它语言是截断(小数点后面直接不要了),而 Python 是向下取整。如果结果为正数的话,截断和向下取整是等价的,所以此时基本所有语言都是一样的。

而结果为负数的话,那么截断和向下取整就不同了,因为 -3.14 截断得到的是 -3、但向下取整得到的是 -4。因此这一点务必要记住,算是 Python 的一个坑吧。话说如果没记错的话,好像只有 Python 采用了向下取整这种方式,别的语言(至少 C、JS、Go)都是截断的方式。

还有一个问题,那就是整数和浮点数之间可不可以相互赋值呢?先说结论:

- 整数赋值给浮点数是可以的;

- 浮点数赋值给整数不行;

# 7 是一个纯数字,那么它既可以在赋值给 int 类型的变量时表示整数 7

# 也可以在赋值给 float 类型的变量时表示 7.0

cdef int a = 7

cdef float b = 7

# 但如果是下面这种形式,虽然也是可以的,但是会弹出警告

cdef float c = a

# 提示: '=': conversion from 'int' to 'float', possible loss of data

# 因为 a 的值虽然也是 7,但它已经具有相应的类型了

# a 是一个 int,将 int 赋值给 float 会警告

# 而将浮点数赋值给整数则不行

# 这行代码在编译的时候会报错:Cannot assign type 'double' to 'int'

cdef int d = 7.0

前面说了,使用 cdef int、cdef float 声明的变量不再是指向 Python 整数对象和浮点数对象的指针,而是 C 在栈上分配的整数和浮点数。尽管 C 整数没有考虑溢出,但是它在做运算的时候是遵循 Python 的规则(主要是除法),那么可不可以让其强制遵循 C 的规则呢?答案是可以的。

cimport cython

# 使用@cython.cdivision(True)装饰器

@cython.cdivision(True)

def divides(int a, int b):

return a / b

文件名还是叫 cython_test.pyx,我们来测试一下。

import cython_test

print(-7 // 2) # -4

# 函数参数 a 和 b 都是整型,相除得到还是整型

# 如果是 Python 语义,那么在转化的时候会向下取整得到 -4

# 但这里是 C 语义,所以是截断得到 -3

print(cython_test.divides(-7, 2)) # -3

除了装饰器的方式,还可以用下面两种方式来指定。

1)通过上下文管理器的方式

cimport cython

def divides(int a, int b):

with cython.cdivision(True):

return a / b

2)通过注释的方式进行全局声明

# cython: cdivision=True

def divides(int a, int b):

return a / b

通过这三种方式,在 Cython 中可以让 C 整型变量的除法遵循 C 的语义。

然后再选择不使用 cython.cdivision,测试一下看看。

def divides(int a, int b):

return a / b

导入执行:

import cython_test

print(-7 // 2) # -4

print(cython_test.divides(-7, 2)) # -4

a 和 b 都是 C 的 int,相除得到的还是 int,而我们没有使用 cython.cdivision,那么默认使用 Python 的语义。相除之后的 -3.5 会向下取整,所以结果不是 -3,而是 -4。

总结

- 使用 cdef int、cdef float 声明的变量的类型不再是 Python 的 int、float,也不再表示 CPython 的 PyLongObject * 和 PyFloatObject *,而就是 C 的整数和浮点数;

- 虽然是 C 的 int 和 float,但在进行运算的时候是遵循 Python 语义的。因为 Cython 就是为了优化 Python 而生的,因此在各个方面都要和 Python 保持一致;

- 但是也提供了一些方式去禁用掉 Python 的语义,而采用 C 的语义。方式就是上面说的那三种,它们专门针对于整除和取模,因为加减乘都是一样的,只有除和取模会有歧义;

另外 Cython 中还有一个 @cdivision_warnings,使用方式和 @cdivision 完全一样,表示:当取模的时候如果两个操作数中有一个是负数,那么会抛出警告。

cimport cython

@cython.cdivision_warnings(True)

def mod(int a, int b):

return a % b

测试一下:

import cython_test

# -7 - (2 * -4) == 1

print(cython_test.mod(-7, 2))

# 提示我们取整操作在 C 和 Python 中有着不同的语义

# 同理 cython_test.mod(7, -2) 也会警告

"""

RuntimeWarning: division with oppositely signed operands, C and Python semantics differ

return a % b

1

"""

# -7 - (-2 * 3) = -1

print(cython_test.mod(-7, -2)) # -1

# 但是这里的 cython_test.mod(-7, -2) 却没有弹出警告,这是为什么呢?

# 很好理解,我们说只有商是负数的时候才会存在歧义

# 但是 -7 除以 -2 得到的商是 3.5,是个正数

# 而正数的表现形式对于截断和向下取整都是一致的,所以不会警告

# 同理 cython_test.mod(7, 2) 一样不会警告

另外这里的警告同时针对 Python 和 C,即使我们事先使用 @cython.cdivision(True) 装饰、将其改变为 C 的语义,也一样会弹出警告。个人觉得 cdivision_warnings 意义不是很大,了解一下即可。

7.2 引用计数和静态字符串类型

我们知道解释器会自动管理内存,方法是通过引用计数来判断一个对象是否应该被回收,引入计数为 0 则对象回收,否则不回收。但是引用计数无法解决循环引用,于是又引入了垃圾回收来弥补引用计数的缺陷。

而 Cython 也会为我们处理所有的引用计数问题,确保 Python 对象(无论是静态声明、还是动态声明)在引用计数为 0 时被销毁。

很好理解,就是说内存管理的问题 Cython 也会负责的。其实不用想也大概能猜到 Cython 会这么做,毕竟 cdef tuple a = (1, 2, 3) 和 a = (1, 2, 3) 底层都指向 PyTupleObject,只不过后者在操作的时候需要先通过 PyObject * 获取类型然后再转化,而前者则省略了这一步。但它们底层都是 CPython 中的结构体,所以内存都由解释器管理。还是那句话,Cython 代码是要被翻译成 C 代码的,在翻译的时候会自动处理内存的问题,当然这点和 Python 也是一样的。

不过当 Cython 中动态变量和静态变量混合时,那么内存管理就会有微妙的影响。我们举个栗子:

# char * 表示 C 的字符串

# 它对应 Python 的 bytes 对象

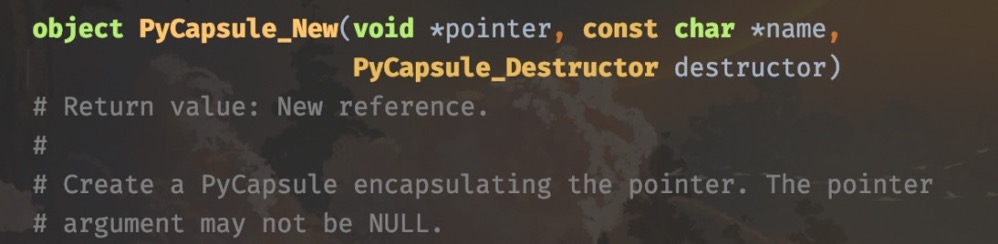

# 但下面这行代码是编译不过去的

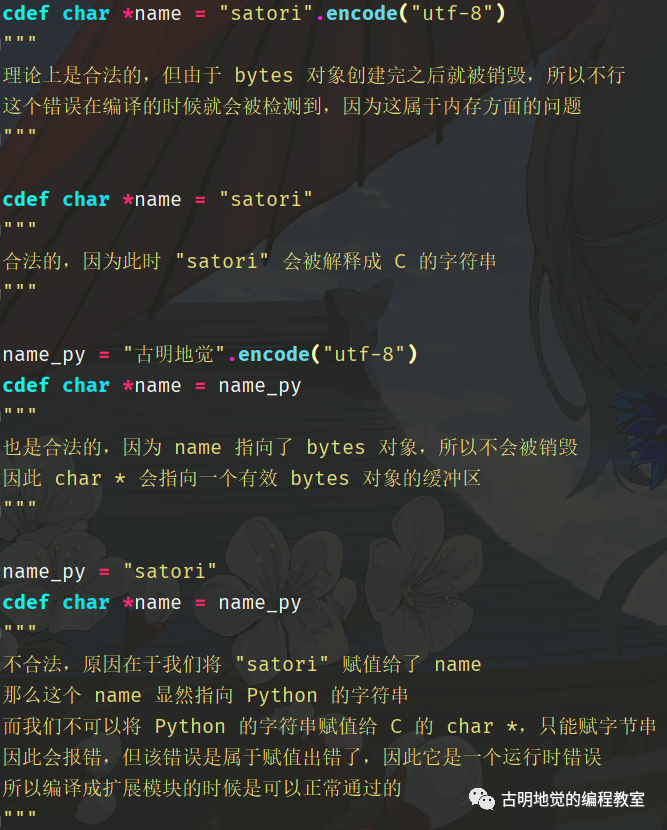

cdef char *name = "古明地觉".encode("utf-8")

编译的时候会失败,咦,不是说后面可以跟一个 bytes 对象吗?话是没错,但问题是这个 bytes 对象是一个临时对象,什么是临时对象呢?就是创建完了却没有变量指向它,准确的说是没有 Python 类型的变量指向它。

因为这里的 name 使用的是 C 的类型,所以它不会增加这个 bytes 对象的引用计数,因此这个 bytes 对象创建出来之后就会被销毁。编译时会抛出:Storing unsafe C derivative of temporary Python reference,告诉我们创建出来的 Python 对象是临时的。

那么如何解决这一点呢?答案是使用变量保存起来就可以了。

# 这种做法是完全合法的

# 因为这个 bytes 对象是被 Python 类型的变量指向了

cdef bytes name_py = "古明地觉".encode("utf-8")

# 或者动态声明也可以:name_py = "古明地觉".encode("utf-8")

cdef char *name = name_py

所以 char * 比较特殊,它底层是使用一个指针来表示字符串。和整型和浮点型不同,cdef long a = 123,这个 123 直接就是 C 中的 long,可以直接使用。

但将 Python 的 bytes 对象赋值给 char *,在 C 的级别 char * 所引用的数据还是由 CPython 进行管理的,因为 bytes 对象内部有一个缓冲区,负责存储具体的数据,而 char * 会直接指向这个缓冲区。但它无法告诉解释器还有一个变量(非 Python 类型的变量)引用它,这就导致了 bytes 对象的引用计数不会加1,而是创建完之后就会被销毁。而 bytes 对象都销毁了,char * 类型的变量也就拿不到内部的数据了。

所以我们需要提前使用 Python 类型的变量(不管是静态声明还是动态声明)将其保存起来,让其引用计数加 1,这样就不会删除了。

那么下面的代码有没有问题呢?如果有问题该怎么改呢?

word1 = "hello".encode("utf-8")

word2 = "satori".encode("utf-8")

cdef char *word = word1 + word2

会不会出问题呢?显然会有大问题,尽管 word1 和 word2 指向了相应的 bytes 对象,但是 word1 + word2 则是会创建一个新的 bytes 对象,这个新的 bytes 对象可没有变量指向。所以这个新创建的 bytes 对象注定是昙花一现,创建完之后会被立刻销毁,因此无法赋值给 char * 变量。

另外创建 char * 还有一种方式:

cdef char *name = "satori"

此时的 "satori" 会被当成是 C 的字符串来解析,所以这种做法也是可以的,不过很明显,它只能是 ascii 字符串。

但下面这种做法不行:

name_py = "satori"

cdef char *name = name_py

char * 需要接收 C 的字符串,但我们赋值给了一个变量,那么它就是 Python 类型了,而 Python 的 str 和 C 的 char * 无法直接转化,两者没有对应关系。于是报错:TypeError: expected bytes, str found。

而 char * 和 Python 的 bytes 是对应的,每个元素都是 0 到 255 的整数。

cdef bytes var_py = b"abc"

# 等价于 C 的 char *var = {'a', 'b', 'c', '\0'};

# 或者 char *var = {97, 98, 99, '\0'};

cdef char *var = var_py

同理 char * 在赋值给 Python 类型的变量时,也会自动转成 bytes 对象,因为这两者是对应的。

# char *name = {'s', 'a', 't', 'o', 'r', 'i', '\0'}

cdef char *name = "satori"

# 赋值给 Python 类型的变量

name_py = name

print(name) # b'satori'

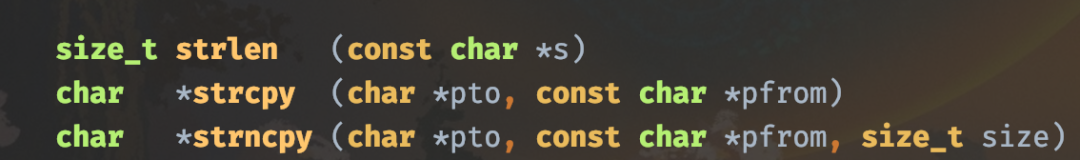

以上就是 char * 相关的内容,它表示 C 的字符串类型,对应 Python 的 bytes。显然它在操作的时候,速度要比 bytes 对象快很多,如果你希望程序运行的更快一些,那么不妨将 bytes 类型替换成 char * 类型。

因此关于 char * 来总结一下:

当然啦,char * 是 C 的字符串类型,Python 也有自己的字符串类型,也就是 str。

cdef str name_py = "satori"

# 通过字面量的方式,"satori" 会被当成 C 字符串来解析

cdef char *name_c = "satori"

print(name_py) # satori

print(name_c) # b'satori'

比较简单,没什么可说的。然后 Cython 还提供了一个 Py_UCS4,它表示只有一个字符的字符串。

def foo(Py_UCS4 single_char):

print(single_char)

# 合法

foo("你")

# 不合法,长度不为 1

foo("你好")

"""

ValueError: only single character unicode strings

can be converted to Py_UCS4, got length 2

"""

以上代码会编译失败,另外 Py_UCS4 表示一个 UNICODE,所以这个 Py_UCS4 还可以换成 Py_UNICODE,效果是一样的,都表示长度为 1 的 Python 字符串。

以上就是字符串相关的内容,str 表示 Python 的字符串类型,char * 表示 C 的字符串类型,对应 Python 的 bytes 类型。使用 char * 的速度会更快,asyncpg 这个数据库驱动在解析数据时就将 bytes 换成了 char *,速度从而得到了很大的提升。

但我们说,C 的类型虽然速度快,可是不够灵活,它使用起来肯定没有 bytes 对象方便。如果你的程序没有到达性能瓶颈,可以考虑不使用 char *,直接使用 bytes 和 str 就行。通过 cdef bytes 和 cdef str 静态声明,速度依旧可以提升,至于要不要使用 char * 就看你自己的需求了。

以上就是静态字符串类型相关的内容,在使用的时候会有一些意想不到的小陷阱,所以需要注意。

8. 使用 def、cdef、cpdef 创建函数

作者:古明地觉

公众号:古明地觉的编程教室

公众号二维码:

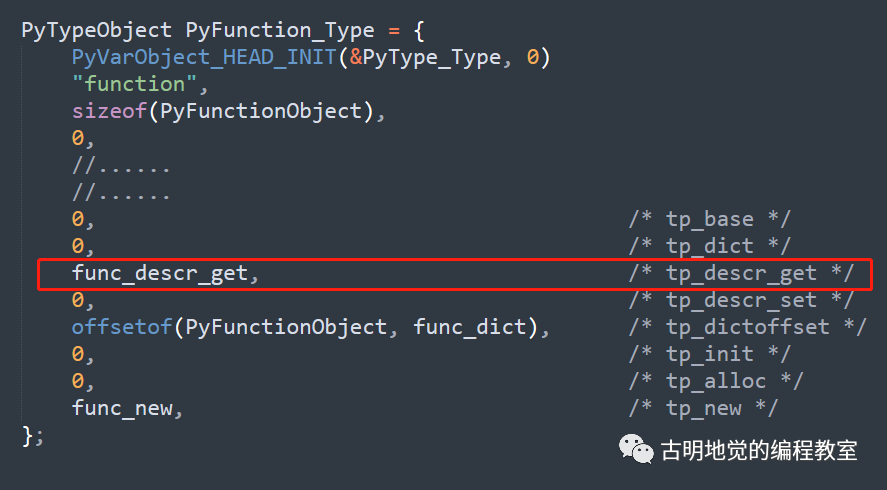

我们前面所学的关于动态变量和静态变量的内容也适用于函数,Python 的函数和 C 的函数都有一些共同的属性:函数名称、接收参数、返回值,但是 Python 中的函数更加的灵活和强大。因为 Python 中一切皆对象,所以函数也是一等公民,可以随意赋值、并具有相应的状态和行为,这种抽象是非常有用的。

一个 Python 函数可以:

- 在运行时动态创建;

- 使用 lambda 关键字匿名创建;

- 在另一个函数(或其它嵌套范围)中定义;

- 从其它函数中返回;

- 作为一个参数传递给其它函数;

- 使用位置参数和关键字参数调用;

- 函数参数可以使用默认值;

C 函数调用开销最小,比 Python 函数快几个数量级。一个 C 函数可以:

- 作为一个参数传递给其它函数,但这样做比 Python 麻烦的多;

- 不能在其它函数内部定义,但这在 Python 中不仅可以、而且还非常常见,毕竟 Python 的装饰器就是通过高阶函数加上闭包实现的;

- 具有不可修改的静态分配名称;

- 只能接受位置参数;

- 函数参数不支持默认值;

正所谓鱼和熊掌不可兼得,Python 的函数调用虽然慢几个数量级(即使没有参数),但是它的灵活性和可扩展性都比 C 强大很多,这是以效率为代价换来的。而 C 的效率虽然高,但是灵活性没有 Python 好,这便是各自的优缺点。

那么说完 Python 函数和 C 函数各自的优缺点之后该说啥啦,对啦,肯定是 Cython 如何将它们组合起来、吸取精华剔除糟粕的啦。

8.1 使用 def 关键字定义 Python 函数

Cython 支持使用 def 关键字定义一个通用的 Python 函数,并且还可以按照我们预期的那样工作。比如:

def rec(n):

if n == 1:

return 1

return n * rec(n - 1)

文件名为 cython_test.pyx,我们来导入它。

import pyximport

pyximport.install(language_level=3)

import cython_test

print(cython_test.rec(10))

"""

3628800

"""

显然这是一个 Python 语法的函数,参数 n 接收一个动态的 Python 变量,但它在 Cython 中也是合法的,并且表现形式是一样的。

我们知道即使是普通的 Python 函数,也可以通过 Cython 进行编译,但是就调用而言,这两者是没有任何区别的。不过执行扩展里面的代码时,已经绕过了解释器解释字节码这一过程;但 Python 代码则不一样,它是需要被解释执行的,因此在运行期间可以随便动态修改内部的属性。我们举个栗子就很清晰了:

Python 版本

# 文件名:a.py

def foo():

return 123

# 另一个文件

from a import foo

print(foo()) # 123

print(foo.__name__) # foo

foo.__name__ = "哈哈"

print(foo.__name__) # 哈哈

Cython 版本

# 文件名:cython_test.pyx

def foo():

return 123

导入测试:

import pyximport

pyximport.install(language_level=3)

from cython_test import foo

print(foo()) # 123

print(foo.__name__) # foo

try:

foo.__name__ = "哈哈"

except AttributeError as e:

print(e)

"""

attribute '__name__' of 'builtin_function_or_method' objects is not writable

"""

我们看到报错了,报错信息告诉我们 builtin_function_or_method 的属性 __name__ 不可写。Python 的函数是一个动态类型函数,所以它可以修改自身的一些属性。

但是 Cython 代码在编译之后,函数变成了 builtin_function_or_method,绕过了解释这一步,因为不能对它自身的属性进行修改。事实上,Python 的内置函数也是不能修改的。

try:

getattr.__name__ = "xxx"

except Exception as e:

print(e)

"""

attribute '__name__' of 'builtin_function_or_method' objects is not writable

"""

内置函数和扩展模块里的函数都是直接指向了底层 C 一级的结构,因此它们的属性是不能够被修改的。

Python 的动态性是解释器将字节码翻译成 C 代码的时候动态赋予的,而 Cython 代码在被编译成扩展模块时,内部已经是机器码了,所以解释器无法再对其动手脚,或者说失去了相应的动态性,但换来的是速度的提升。但很明显,当前速度的提升是不大的,因为我们没有做类型标注,也就是没有基于类型进行优化。

回到上面用递归计算阶乘的例子上来,显然 rec 函数里面的 n 是一个动态变量,如果想要加快速度,就要使用静态变量,也就是规定好类型。

def rec(int n):

if n == 1:

return 1

return n * rec(n - 1)

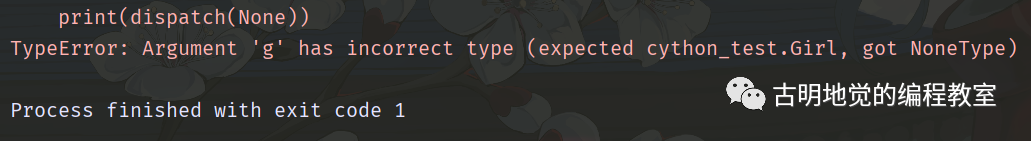

此时当我们传递的时候,会将值转成 C 中的 int,如果无法转换则会抛出异常。

另外在 Cython 中定义任何函数,我们都可以将动态类型的参数和静态类型的参数混合使用。Cython 还允许静态参数具有默认值,并且可以按照位置参数或者关键字参数的方式传递。

# 这样的话就可以不传参了,默认 n 是 10

def rec(int n=10):

if n == 1:

return 1

return n * rec(n - 1)

这么做虽然可以提升效率,但提升幅度有限。因为这里的 rec 还是一个 Python 函数,它的返回值也是一个 Python 的整数,而不是静态的 C int。

因此在计算 n * rec(n - 1) 的时候,Cython 必须生成大量代码,将返回的 Python 整型转成 C int,然后乘上静态类型的变量 n。最后再将结果得到的 C int 打包成 Python 的整型,所以整个过程还是存在可以优化的地方。

那么如何才能提升性能呢?显然可以不使用递归、而是使用循环的方式,当然这个我们不谈,因为这个 Cython 没啥关系。我们想做的是告诉 Cython:"函数返回的是一个 C int,你在计算的时候不要有 Python 的整型参与。"

那么要如何完成呢?往下看。

8.2 使用 cdef 关键字定义 C 函数

cdef 关键字除了创建变量之外,还可以创建具有 C 语义的函数。cdef 定义的函数,其参数和返回值通常都是静态类型的,它们可以处理 C 指针、结构体、以及其它一些无法自动转换为 Python 类型的 C 类型。

所以把 cdef 定义的函数看成是长得像 Python 函数的 C 函数即可。

cdef int rec(int n):

if n == 1:

return 1

return n * rec(n - 1)

我们之前的例子就可以改写成上面这种形式,我们看到结构非常相似,主要区别就是指定了返回值的类型。

因为指定了返回值的类型,此时的函数是没有任何 Python 对象参与的,因此不需要从 Python 类型转化成 C 类型。该函数和纯 C 函数一样有效,调用函数的开销最小。

所以在使用 cdef 定义函数时,格式为:cdef 类型 函数名。并且 cdef 函数返回的类型可以是任何的静态类型(如:指针、结构体、C数组、静态 Python 类型),如果不指定类型,也就是 cdef 函数名 的格式,那么返回值类型默认为 object。

另外,即便是 cdef 定义的函数,我们依旧可以创建 Python 对象和动态变量,或者接收它们作为参数也是可以的。

# 合法,返回的是一个 list 对象

cdef list f1():

return []

# 等价于 cdef object f2()

# 而 Python 中任何对象都是 object 类型

cdef f2():

pass

# 虽然要求返回列表

# 但是返回 None 也是可以的(None 特殊,后面会说)

cdef list f3():

pass

# 同样道理

cdef list f4():

return None

# 这里是会报错的

# TypeError: Expected list, got tuple

cdef list f5():

return 1, 2, 3

使用 cdef 定义的函数,可以被其它的函数(cdef 和 def 都行)调用,但是 Cython 不允许从外部的 Python 代码来调用 cdef 函数,我们之前使用 cdef 定义的变量也是如此。因为 cdef 定义的函数相当于是 C 函数,可以返回任意的 C 类型,而某些 C 类型在 Python 中无法与之对应。

所以我们通常会定义一个 Python 函数,然后让 Python 函数来调用 cdef 定义的函数,所以此时的 Python 函数就类似于一个包装器,用于向外界提供一个访问的接口。

cdef int _rec(int n):

if n == 1:

return 1

return n * rec(n - 1)

def rec(n):

return _rec(n)

def 函数效率不高,但它可以被 Python 代码访问;cdef 函数效率虽然高,但是无法被 Python 代码访问。于是我们可以定义一个 cdef 函数,用来执行具体的代码逻辑,然后再定义一个 def 函数,负责调用 C 函数,也就是给外部的 Python 代码提供一个接口。

通过 cdef 和 def 结合,从而实现最优的效果。因为计算逻辑都发生在 C 函数中,Python 函数只是提供一个包装而已,不负责实际代码的执行。这样就既保证了效率,又保证了外部的 Python 代码可以访问。

可能有人觉得,调用一个 Python 函数的开销会比调用 C 函数要大吧。这里的开销不包括函数体内部代码的执行时间,而是指调用函数本身的开销,也就是从调用函数、到开始执行函数内部代码之间的这段开销。很明显,调用 def 函数的开销是要比 cdef 函数大的。

可能有小伙伴觉得能不能把函数调用本身的开销也给优化一下,答案是不能,因为 cdef 定义的函数无法被外部的 Python 访问。如果你希望 Cython 里面的函数能够被外部的 Python 调用,要么将逻辑使用 def 函数实现,要么交给 cdef 函数实现、然后再定义一个 def 函数作为包装器。

总之我们可以对函数体内部的代码逻辑进行优化,但函数调用本身的开销是无法避免的。正如之前说的,Python 程序再怎么优化,在极限上也不可能和静态语言相媲美。而且 Cython 是为 Python 服务的,在函数调用时,Python 数据要转成 C 数据、在函数返回时,C 数据还要再转成 Python 数据,这些也是有开销的。

因此即便引入了 Cython,在极限上,Python 还是无法与 C++、Rust 之类的静态语言相抗衡。

当然啦,相比函数调用本身和返回时的数据类型转换,这些开销实际上微不足道,重点是函数体内部代码的执行逻辑,它们才是需要优化的地方。如果函数体内部的代码已经优化到极致了,还达不到内心的预期,甚至连函数调用本身的开销都需要成为优化的地方(比如一个 Python 函数需要调用一百万次),那最好的方式就是换一门静态语言,比如 Rust。

8.3 使用 cpdef 结合 def、cdef

我们在 Cython 中定义一个函数可以使用 def 和 cdef,但还有第三种定义函数的方式,也就是使用 cpdef 关键字声明。cpdef 是 def 和 cdef 的混合体,结合了这两种函数的特性,并解决了局限性。

我们之前使用 cdef 定义了一个函数 _rec,但是它无法被外部访问,因此又定义了一个 Python 函数 rec 供外部调用,相当于提供了一个接口。所以我们需要定义两个函数,一个是用来执行逻辑的(C 版本),另一个是让外部访问的(Python版本),一般这种函数我们称之为 Python 包装器。很形象,C 版本不能被外部访问,因此定义一个 Python 函数将其包起来。

但是 cpdef 定义的函数会同时具备这两种身份,也就是说,一个 cpdef 定义的函数会自动为我们提供上面那两种函数的功能,怎么理解呢?从 Cython 中调用函数时,会调用 C 的版本,在外部的 Python 中导入并访问时,会调用包装器。这样的话,cpdef 函数就可以将 cdef 函数的性能和 def 函数的可访问性结合起来了。

因此上面那个例子,我们就可以改写成如下:

cpdef int rec(int n):

if n == 1:

return 1

return n * rec(n - 1)

如果是之前的方式,则需要两个函数,这两个函数还不能重名,但是使用 cpdef 就不需要关心了,使用起来会更方便。

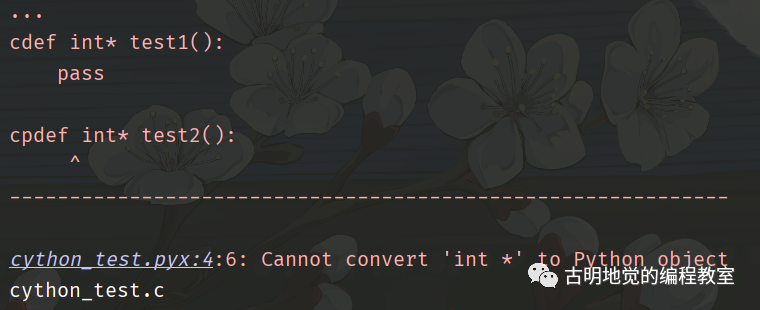

需要注意,cpdef 和 cdef 一样,支持定义函数的时候指定返回值类型,从而实现基于类型的优化(def 函数不可以指定返回值类型,但参数类型可以指定)。但 cpdef 函数毕竟是可以被外部的 Python 访问的,因此在指定返回值类型的时候就会受到限制,cpdef 函数指定的返回值类型要和 Python 的某个类型能够对应。举个例子:

cdef int* test1():

pass

cpdef int* test2():

pass

这段代码编译的时候会报错,原因在于 test2 函数的返回值类型声明有问题。首先 test1 是一个 cdef 函数,它的返回值类型不受限制,因为外部的 Python 代码无法访问。但 test2 不行,它支持外部的 Python 代码访问,所以返回值类型要能和 Python 的某个类型相对应,但很明显,Python 里面没有哪个类型可以和 C 的指针相对应,于是编译错误。

所以使用 cpdef 定义函数的时候,返回值类型有一些限制,当然还有参数类型。因为 cpdef 函数要同时兼容 Python 和 C,这意味着它的参数和返回值类型必须同时兼容 Python 类型和 C 类型。但我们知道,并非所有的 C 类型都可以用 Python 类型表示,比如:C 指针、C 数组等等,所以它们不可以作为 cpdef 函数的参数类型和返回值类型。

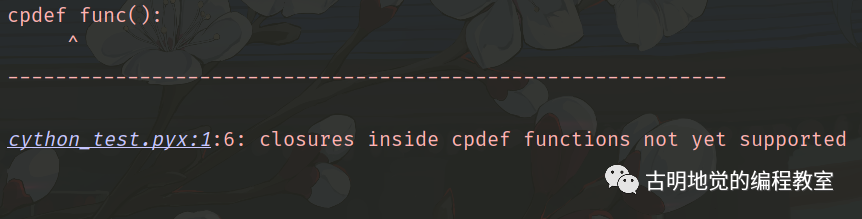

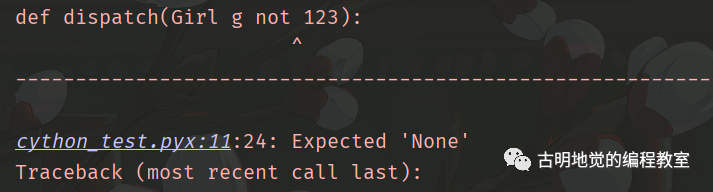

除此之外,cpdef 函数还有一个局限性,就是它的内部不可以出现闭包。

# 不指定返回值类型,默认为 object

cpdef func():

lam = lambda x: x

显然上述逻辑在 def 定义的函数中再正常不过了,但如果是 cpdef 的话,那么编译的时候会报错。

报错信息很直观,在 cpdef 函数内部定义闭包还不支持,说白了就是我们不可以在 cpdef 函数里面再定义函数,包括匿名函数。所以如果需要使用闭包,那么还是建议通过 cdef 函数加上 def 函数作为包装器的方式,def 和 cdef 都是支持闭包的。另外,使用闭包时,内层函数必须是 Python 的 def 函数或者匿名函数。

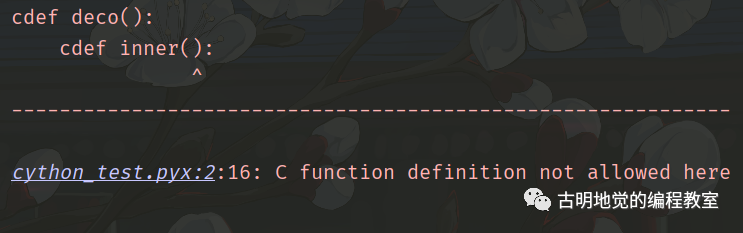

cdef deco():

cdef inner():

pass

上面的代码会报错,虽然 cdef 支持闭包,但是内层函数必须是 def 函数或者匿名函数。我们不能在一个函数里面去定义一个 cdef 函数,也就是说,cdef 函数在定义的时候,位置是有讲究的。

报错信息也很明显,cdef 定义的 C 函数不可以出现在当前的位置,cpdef 也是同理。当然不光是函数,像 if, for, while 等语句的内部也不可以。

if 2 > 1:

cdef f1():

pass

while 1:

cdef f2():

pass

for i in range(10):

cdef f3():

pass

上面三个 cdef 函数的出现位置都是不允许的,在编译的时候就会报错:cdef statement not allowed here,cpdef 函数也是同理。

所以 cdef 定义的 C 函数应该出现在最外层,或者说没有缩进的地方。如果有缩进,那么应该是在类里面,作为类的成员函数,关于类我们后面会说。

总结一下:

1)cdef 和 def 一样,不会受到闭包的限制,但 def 起不到加速效果,cdef 无法被外界访问;

2)cpdef 是两者的结合体,既能享受加速带来的收益,又能自动提供包装器给外界;

3)但 cpdef 在闭包语法上会受到限制,内部无法定义函数,因此最完美的做法是使用 cdef 定义函数之后再手动提供包装器。但是当不涉及到闭包的时候,还是推荐使用 cpdef 定义的;

8.4 内联函数

在 C 和 C++ 中,定义函数时还可以使用一个可选的关键字 inline,这个 inline 是做什么的呢?我们知道 C 和 C++ 的函数调用也是有开销的(即使很微小),因为要涉及到跳转、压栈、创建栈帧等一般性操作。而定义函数时使用 inline 关键字,那么代码会被放在符号表中,在使用时直接进行替换(像宏一样展开),这样就没有了调用的开销,提高效率。

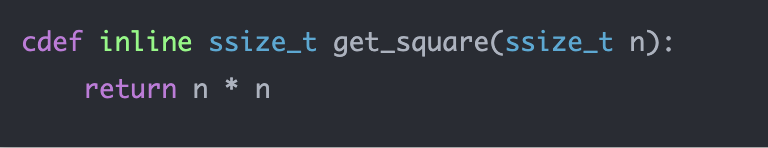

Cython 同样支持 inline(但在 Cython 中不是关键字),使用时只需要将 inline 放在 cdef 或者 cpdef 后面即可,但是不能放在 def 后面。

当调用 get_square 函数的时候,会将函数内部的代码直接贴过来,此时不涉及函数的调用,从而减少开销。

inline 如果使用得当,可以提高性能,特别是在深度嵌套循环中调用的小型内联函数。因为它们会被多次调用,这个时候通过 inline 可以省去函数调用的开销。

可能有人觉得,既然 inline 可以省去函数调用时的开销,并且使用上还能像函数一样,那能不能每次声明函数的时候都加上 inline 呢?显然这种做法不可取,因为内联函数是以代码膨胀为代价的,你在任何地方调用内联函数都会把函数内的代码拷贝一份,这样会消耗很多的内存空间。如果函数体内的代码执行时间比较长,那么节省下来的函数调用的开销,与之相比意义不是很大。

因为函数调用本身的开销非常微小,所以只有当函数体逻辑简单、并且还要在深度嵌套循环中反复调用的情况下,才会使用内联函数。

另外 inline 只是一个对编译器的建议,至于最后到底是否内联,还要看编译器的意思。如果编译器认为函数不复杂、以及不涉及递归,可以在调用点展开,就会真正内联。所以并不是使用了 inline 就会内联,使用 inline 只是给编译器一个建议。

以上就是如何在 Cython 中定义函数,总共提供了三种方式,都各有优缺点,需要在工作中搭配结合使用。

9. Cython 的异常处理

作者:古明地觉

公众号:古明地觉的编程教室

公众号二维码:

def 定义的函数在 C 的级别总是会返回一个 PyObject *,这个是恒定的,不会改变,因为 Python 的变量本质上就是一个 PyObject *。因此正常调用一个函数时,它的返回值一定指向了一个合法的 Python 对象。

但如果报错了,在 C 的层面返回的就不再是 PyObject *,而是一个 NULL。解释器在返回 NULL 之前,会将异常信息写入到 stderr(标准错误输出)里面。对于 Python 使用者而言,表现就是:先输出一堆错误信息,然后解释器中止运行。

cpdef test():

lst = [0]

# 显然会索引越界

lst[3]

return None

文件名仍叫 cython_test.pyx,我们测试一下。

import pyximport

pyximport.install(language_level=3)

import cython_test

print(cython_test.test())

"""

Traceback (most recent call last):

File "...", line 5, in <module>

print(cython_test.test())

File "cython_test.pyx", line 1, in cython_test.test

cpdef test():

File "cython_test.pyx", line 4, in cython_test.test

lst[3]

IndexError: list index out of range

"""

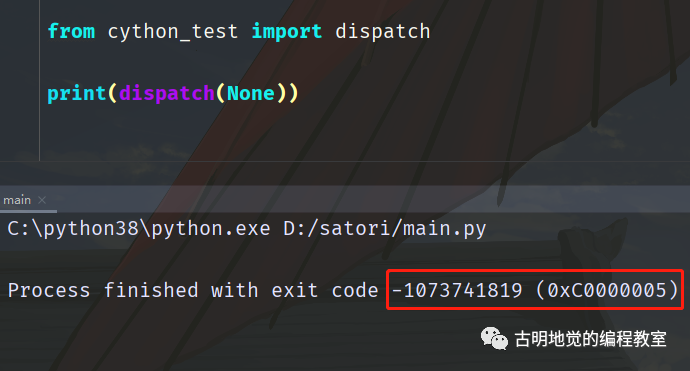

如果程序正常执行完毕,返回的状态码为 0;执行的时候报错了,返回的状态码为 1;如果返回的状态码很古怪,是一个乱七八糟的数字,那么说明解释器内部出现了异常,这种情况基本只有在写 C 扩展的时候才会发生。

总之,解释器抛出异常的本质就是,发现程序出错了,然后将错误信息写入到标准错误输出当中,然后 return NULL 并停止运行。

所以异常输出在 Cython 中的表现也是一样的,它允许 Cython 正确地从函数中抛出异常。但这有一个前提,那就是函数的返回值必须是 Python 类型,显然对于 def 函数是没有问题的。而 cdef 和 cpdef 可能会返回一个非 Python 类型,那么此时则需要一些其它的异常提示机制。

我们举个例子:

cpdef long test():

lst = [0]

# 显然会索引越界

lst[3]

return 123

此时 test1 的返回值类型是 C 的类型,并且里面的代码会报错,那么 Python 在调用的时候会不会将异常抛出来呢?

import pyximport

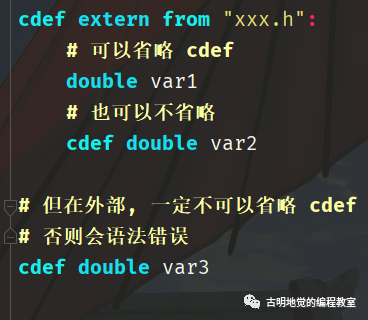

pyximport.install(language_level=3)

import cython_test

print(cython_test.test())

"""

IndexError: list index out of range

Exception ignored in: 'cython_test.test'

Traceback (most recent call last):

File "...", line 5, in <module>

print(cython_test.test())

IndexError: list index out of range

0

"""

print("我会执行吗?")

"""

我会执行吗?

"""

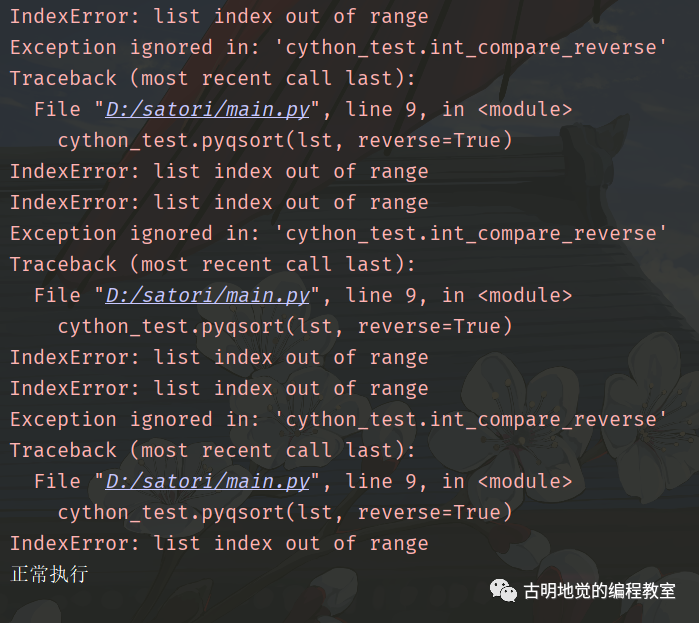

我们看到了神奇的一幕,程序报错了,但是没有停止运行,而是将异常忽略掉了。并且当函数内部出异常的时候,自动返回零值。

CPython 在判断是否出现异常的时候,首先会根据返回值来判断。如果返回值的类型是 PyObject *,那么正常执行一定会返回一个非 NULL 指针,因为要指向一个合法的 Python 对象;可要是出现异常,那么就会返回一个空指针 NULL,代表函数执行失败,应该将异常抛出来。

因此在调用一个返回值为 Python 类型的函数时,根据返回值是否为 NULL 可以很轻松地判断调用是否出异常。所以当异常发生在 def 函数、或者返回值为 Python 类型的 cdef、cpdef 函数中,那么表现和 Python 代码是一致的。

但如果返回值是一个 C 的类型(针对 cdef 和 cpdef 函数),比如这里返回的是 long 类型,那么执行出错时会设置异常、并返回 0,也就是对应类型的零值。但问题是解释器不知道此时的 0,是因为调用出错返回的 0,还是正常执行完毕后返回的 0,因为返回值也可能是 0。

所以当返回值是 C 的类型时,如果函数调用出错,那么异常没有办法传递给它的调用方。换句话说就是异常没有办法向上抛,最终的结果就是将异常输出到 stderr 当中,但是却无法停止运行。

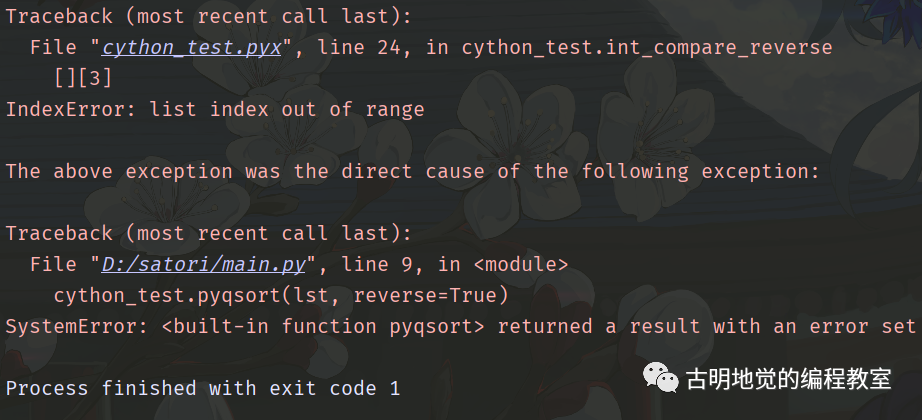

而为了正确传递异常,Cython 提供了一个 except 字句,允许 cdef、cpdef 函数和调用方通信,如果函数在执行过程中发生了 Python 异常,要将它抛出来。

cpdef long test() except -1:

lst = [0]

# 显然会索引越界

lst[3]

return 123

此时再调用的话,会有什么结果呢?异常能正常抛出来吗?

import pyximport

pyximport.install(language_level=3)

import cython_test

print(cython_test.test())

print("我会执行吗?")

"""

Traceback (most recent call last):

File "...", line 5, in <module>

print(cython_test.test())

File "cython_test.pyx", line 1, in cython_test.test

cpdef long test() except -1:

File "cython_test.pyx", line 4, in cython_test.test

lst[3]

IndexError: list index out of range

"""

我们看到此时异常就正确地传递给调用方了,当出现异常时,将异常信息打印出来,然后中止运行。

所以 except -1 相当于充当异常发生时的哨兵,当然啦不仅是 -1,任何整数都是可以的。但是还有一个问题,如果返回值恰好也是 -1 怎么办?我们举个例子:

cpdef int test(int i, int j) except -1:

return i // j

这里需要写成 i // j,不能写 i / j,因为返回值是 int 类型,而 i / j 得到的是浮点数。虽然在变量赋值的时候,表达式计算得到的浮点数会自动向下取整,但此处不行,我们必须显式地返回一个整数。

然后测试一下:

import pyximport

pyximport.install(language_level=3)

import cython_test

try:

cython_test.test(3, 0)

except ZeroDivisionError as e:

print(e)

"""

integer division or modulo by zero

"""

print(ext.test(3, -3))

"""

Traceback (most recent call last):

File "...", line 14, in <module>

print(cython_test.test(3, -3))

SystemError: <built-in function test> returned NULL without setting an error

"""

神奇的地方出现了,虽然异常依旧能够正常抛出来,但是当返回值为 -1 时居然又抛出了一个 SystemError。

如果你使用 C 编写过扩展模块的话,应该会遇见过这个问题。前面说了,Python 的函数一定会返回一个 PyObject *,但如果函数执行出错了,那么在 C 一级就会返回一个 NULL,并且将发生的异常设置进去。

如果返回了 NULL 但是没有设置异常的话,就会抛出上面的那个错误。因为解释器发现函数返回了 NULL,所以知道出现异常了,于是会将回溯栈里设置好的异常信息打印出来,告诉开发者出现异常的具体原因,到底是哪部分代码出错了。但问题是解释器发现异常回溯栈是空的,所以会抛出一个 SystemError,表示函数返回了 NULL,但却没有设置异常。

而出现上述结果的原因就是我们这里的 except -1,它允许 -1 充当异常发生时的哨兵。但如果函数正常执行、只是返回的恰好是 -1,那么也表示发生异常了,于是底层会返回NULL。然而实际上异常并没有发生,所以没有设置异常,而解释器又发现返回值为 NULL,所以提示我们 returned NULL without setting an error。

一个比较笨的解决办法是将 except -1 换成 except -2,显然这是治标不治本,因为当返回值为 -2 的时候还是可能会出现上面的结果。所以能不能有这样一种机制,就是当返回值恰好和哨兵相等时,让解释器去看一眼异常回溯栈。如果回溯栈为空,证明没有执行出错,而是返回值和哨兵恰好相等,那么此时就不要返回 NULL 了,因为没有报错,所以应该将返回值正常返回。

cpdef int test(int i, int j) except ? -1:

return i // j

我们在 except 后面加上了一个问号,来看看执行结果。

import pyximport

pyximport.install(language_level=3)

import cython_test

print(cython_test.test(3, -3)) # -1

此时就没有问题了。

总结一下,except ? -1 只是单纯为了在发生异常的时候能够往上抛,这里可以是 -1、也可以是其它的什么值。而函数如果也返回了相同的值,那么就会检测异常回溯栈,如果为空(表示没有报错)就会正常返回。而触发检测的条件就是中间的那个 ?,如果不指定 ?,那么当函数返回了和哨兵相同的值,也是会报错的,因此这个时候你应该确保函数不可能返回 except 后面指定的值(哨兵)。

但很明显,这样的逻辑不具备可靠性,还是在 except 后面加上 ? 要更保险一些。

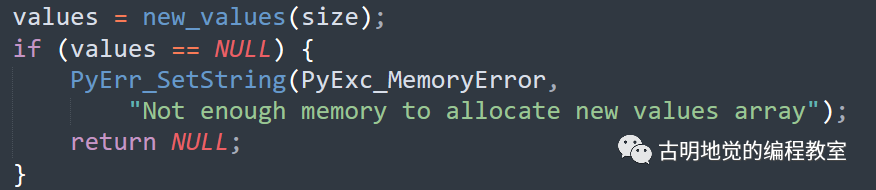

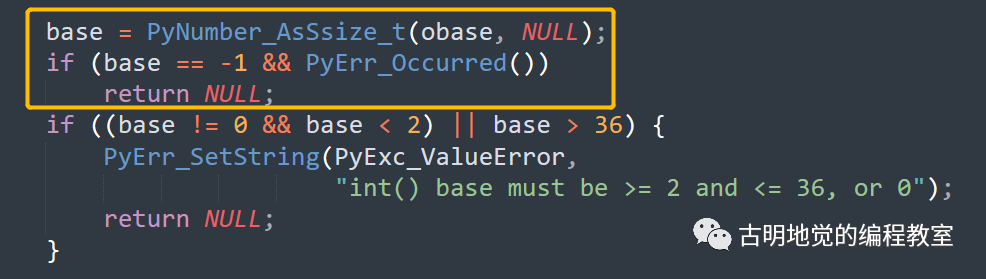

事实上,在 CPython 源码内部也有大量相似的判断逻辑。

调用 new_values 如果成功,那么 values 一定指向一个合法的 Python 对象,但如果调用失败,values 则为 NULL。所以下一步就要判断 values 是不是等于 NULL,如果等于 NULL,证明执行失败了,应该设置异常、然后返回 NULL。而解释器发现为 NULL 了,证明执行出现异常了,于是会将回溯栈里的异常信息打印出来,然后中止运行。

所以当返回值是 PyObject * 时,根据返回值是否为 NULL 即可判断执行是否出现了异常。但如果返回值不是 PyObject *、或者说不是 Python 类型呢?比如是 C 的整型。

我们看到 CPython 内部也是使用 -1 充当的哨兵,如果返回值不是 -1,证明正常执行。如果返回值是 -1,则说明有可能出异常了,此时需要调用 PyErr_Occurred 检测回溯栈是否为空,如果不为空,证明确实出现异常了;如果为空则证明没有出现异常,只是返回值恰好是 -1。

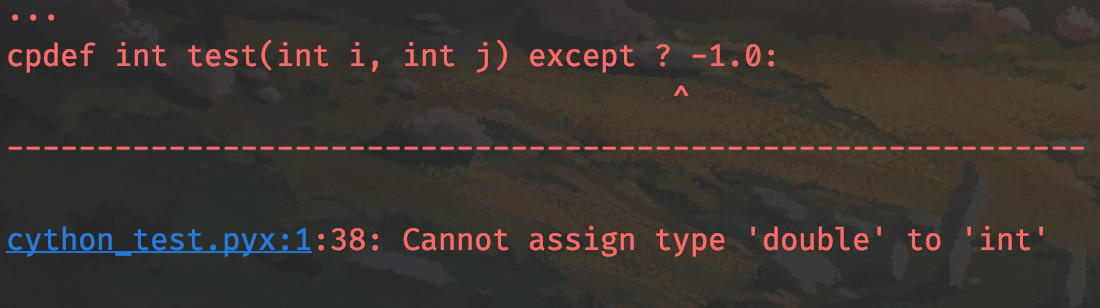

另外哨兵的值要和返回值类型相匹配,返回值类型为整型,那么哨兵可以是任意的整数;返回值类型是浮点型,那么哨兵可以是任意的浮点数。如果我们将 -1 改成 -1.0 的话:

编译的时候报错了,因为哨兵的值的类型和返回值类型不兼容。

所以工作中建议加上 except ? val 作为异常传递的哨兵,val 的值任意,只要和返回值类型匹配即可。但只有当返回值是 C 的类型时,才需要这么做。如果返回值是 Python 类型,那么使用 except 子句会报错,比如下面的代码就是不合法的。

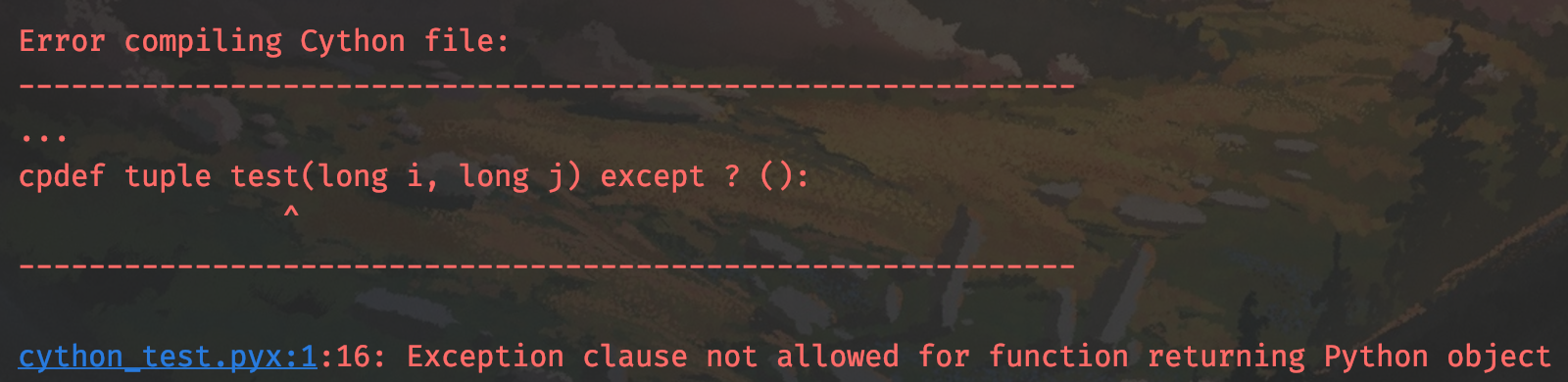

cpdef tuple test(long i, long j) except ? ():

pass

我们的本意是使用空元组作为异常传递的哨兵,但当返回值为 Python 类型时,异常是可以正常抛的,它的表现和 Python 是一致的。只有当返回值是 C 的类型,才需要哨兵,所以上面的代码属于画蛇添足,反而会编译错误。

报错信息很明显,当返回值是 Python 类型时,不允许使用 except 子句。

以上就是 Cython 中的异常处理,准确来说是异常在 Cython 中的一个坑,因为当返回值是 C 的类型时,异常无法正常抛给调用方,需要使用哨兵。至于异常处理本身(try except),在 Cython 和 Python 中的表现都是一致的。

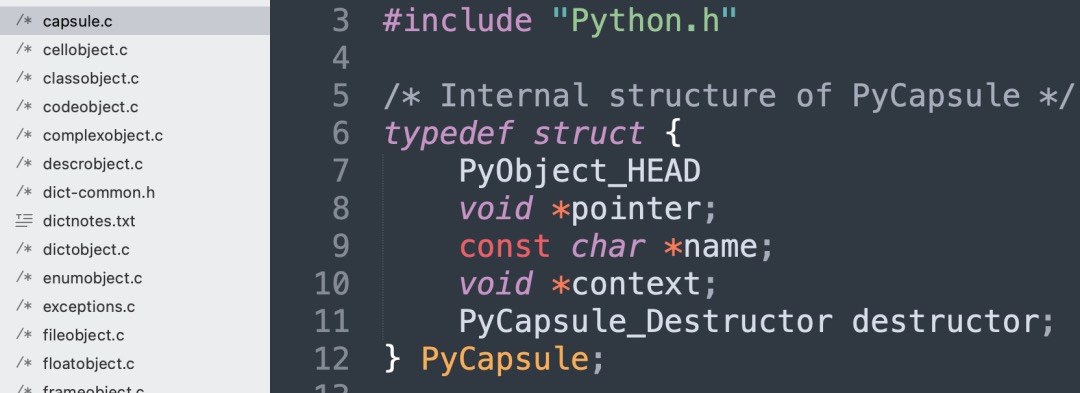

10. Cython 中的类型转换

作者:古明地觉

公众号:古明地觉的编程教室

公众号二维码:

C 和 Python 在数据类型上都有各自的成熟特性,比如支持数据在不同类型之间进行转换。

# Py_ssize_t 是 ssize_t 的别名

cdef Py_ssize_t num = 123

# 声明一个指针类型的变量

cdef Py_ssize_t *p = &num

# 转成浮点型指针

cdef double *p2 = <double *> p

指针类型可以任意转换,这里我们将整型指针转成了浮点型指针,显然这是合法的。在 C 里面类型转换使用的是小括号,这里使用的是尖括号。

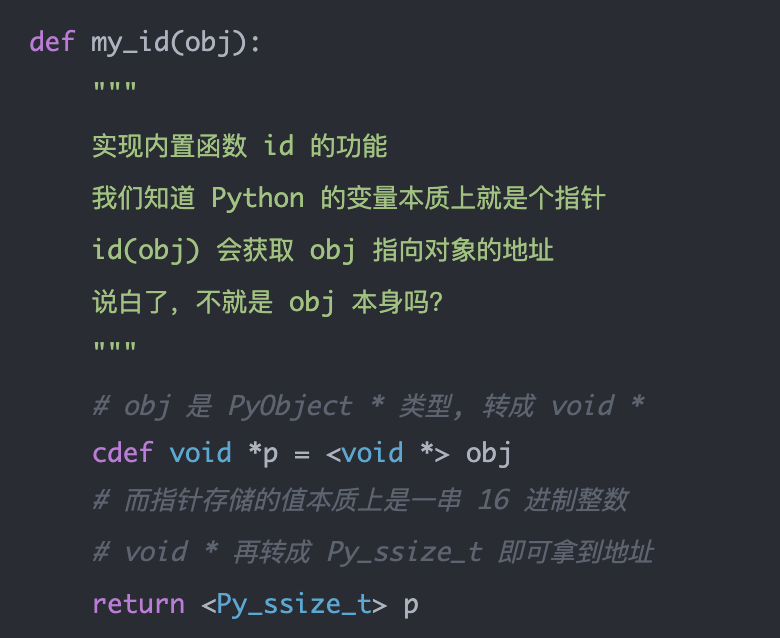

由于指针类型的转换不受限制,所以我们可以手动实现内置函数 id 的功能。

我们来测试一下:

import pyximport

pyximport.install(language_level=3)

import cython_test

num = 123

print(cython_test.my_id(num))

print(id(num))

"""

140706631063024

140706631063024

"""

s = "古明地觉"

print(cython_test.my_id(s))

print(id(s))

"""

2125601466576

2125601466576

"""

print(cython_test.my_id(object))

print(id(object))

"""

140706630839120

140706630839120

"""

我们实现的函数 my_id 和内置函数 id 打印的结果是一样的,所以 Python 虽然一切皆对象,但我们操作的都是指向对象的指针,也就是通过指针来间接操作对象。所以 id(obj) 表示的不是获取 obj 的地址,而是 obj 指向对象的地址,如果站在 C 的角度,那么就是 obj 存储的值本身。

所以 id 函数所做的事情就是把变量存储的地址转成 10 进制整数返回,我们如果想实现 id 函数的功能,只需要将变量(PyObject *)转成 void *,因为不同类型的指针可以相互转换,虽然转换之后指针的含义变了,但存储的地址不变。然后再将 void * 转成 Py_ssize_t,即可拿到存储的地址。

可能有人好奇,为什么先要转成 void * 之后,才能转成整型呢?直接转成整型不行吗?我们来测试一下,这两者的区别。

def my_id1(obj):

# 先转成 void *,再转成 Py_ssize_t

return <Py_ssize_t> <void *> obj

def my_id2(obj):

# 直接转成 Py_ssize_t

return <Py_ssize_t> obj

num = 666

print(my_id1(num))

print(my_id2(num))

"""

1617542740432

666

"""

区别很明显了,因为 Python 的变量是一个指向值的指针。如果转换之后的类型是指针类型,那么转换的是变量;如果转换之后的类型不是指针类型,那么转换的是对象。

所以 my_id2 返回的是 666,由于转换之后的类型不是指针类型,因此参与转换的是对象,相当于将 Python 整数转成了静态的 C 整数。并且 num 必须指向一个整数,否则它无法和 C 的 Py_ssize_t 类型相对应。

而对于 my_id1 函数,转换之后的类型是指针类型,所以参与转换的是变量、即 PyObject *。任何指针都可以和 void * 转换,因此先将变量转成 void *,然后再由 void * 转成整型,而此时打印的是对象的地址。

另外再补充一点,我们前面说指针的转换不受限制,针对的是纯 C 代码。但现在不是纯 C,而是 Cython,所以指针转换还是有限制的,这个限制主要针对 PyObject *,它只能转成 void *。

<int *> obj

像上面的代码是有问题的,Python 类型的变量在指针转换的时候,只能转成 void *。当然啦,char * 是个例外。

name = b"satori"

print(<char *> name) # b'satori'

char * 表示 C 的字符串类型,上述代码做的事情就是将 Python 字节串转成 C 字符串,当然打印的时候还是以 Python 字节串的形式打印的。所以 char * 算是一个例外吧,在 Cython 里面是把 char * 整体作为一个基础类型来看的,并且在转换的时候 name 必须指向一个 bytes 对象,否则会转换失败,因为 char * 和 Python 里面的 bytes 是相对应的。

但是我们发现,无论是指针类型、还是常规类型,这里都是 C 的类型。那么可不可以转成 Python 类型呢?答案是可以的,来看个例子。

def func(a):

cdef list lst1 = list(a)

print(lst1)

print(type(lst1))

cdef list lst2 = <list> a

print(lst2)

print(type(lst2))

func([1, 2, 3])

"""

[1, 2, 3]

<class 'list'>

[1, 2, 3]

<class 'list'>

"""

func((1, 2, 3))

"""

[1, 2, 3]

<class 'list'>

(1, 2, 3)

<class 'tuple'>

"""

打印的结果很明显,如果是 list(a),那么会根据 a 指向的对象创建一个新的列表,所以 lst1 一定指向一个列表。但 <list> a 则是将变量 a、也就是 PyObject * 拷贝一份,然后转成 PyListObject *,相当于将动态变量转成静态变量。

第一次调用 func,参数 a 指向了一个列表,但它是泛型指针。于是通过 <list> a 将它转成静态的,在操作的时候可以避免一些额外开销,当然不管是动态还是静态,指向的都是列表。另外这个例子有点刻意了,其实直接 cdef list lst2 = a 就可以了,因为做好了类型标注,那么会自动转换。

然后第二次调用 func,参数 a 指向了一个元组,显然对于 list(a) 是没有影响的,因为它会创建新列表。但 <list> a 就有问题了,因为 a 实际指向的是元组,应该是 <tuple> a,所以转换失败。在早期的 Cython 中会引发一个SystemError,但目前不会了,如果转换失败还保留原来的类型。

可如果我们希望在无法转换的时候报错,这个时候要怎么做呢?

def func(a):

# 将 <list> 换成 <list?> 即可

cdef list lst2 = <list?> a

print(lst2)

print(type(lst2))

此时传递其它对象就会报错了,比如我们传递了一个元组,会报出 TypeError: Expected list, got tuple。其实,如果类型不对希望报错的话,还有一个最简单的做法, 直接 cdef list lst2 = a 即可。

尖括号里面的类型可以任意,包括 C 类型以及 Python 内置类型。但说实话,使用尖括号做类型转换的场景不是很多,我们通过 cdef 指定类型时,会自动转换,但转化失败则会报错(相当于 <...?>)。当然后续,我们也会给出使用尖括号做类型转换的一些最佳实践。

11. 在 Cython 中声明结构体、共同体、枚举

作者:古明地觉

公众号:古明地觉的编程教室

公众号二维码:

C 语言里面存在结构体、共同体、枚举,而这些在 Cython 里面也是支持的,只不过声明的方式不太一样,下面来看一看。

11.1 结构体

在 C 里面定义一个结构体,一般有两种方式。

#include <stdio.h>

// 直接定义,此时 struct Girl 整体是一个类型

struct Girl {

char *name;

int age;

};

// 使用 typedef 起一个别名

// 此时 Boy 是一个类型

typedef struct {

char *name;

int age;

} Boy;

int main() {

// 声明一个 struct Girl 类型的实例

struct Girl g;

g.name = "mercy";

g.age = 37;

// 声明一个 Body 类型的实例

Boy b;

b.name = "hanzo";

b.age = 38;

printf("name = %s, age = %d\n", g.name, g.age);

printf("name = %s, age = %d\n", b.name, b.age);

/*

name = mercy, age = 37

name = hanzo, age = 38

*/

}

以上是 C 的结构体,在 Cython 里面要如何定义呢?

# 相当于 C 的 struct Girl{...};

cdef struct Girl:

char *name

int age

# 相当于 C 的 typedef struct {...} Boy;

ctypedef struct Boy:

char *name

int age

# 创建结构体实例,无论结构体使用哪一种方式定义

# 在创建实例的时候,格式都是一样的

cdef Girl g1

cdef Boy b1

# 创建的时候也可以直接赋值,支持位置参数和关键字参数

# 但是使用关键字参数要注意顺序

# 结构体字段出现的顺序,就是参数的顺序

cdef Girl g2 = Girl("mercy", 37)

cdef Boy b2 = Boy("hanzo", age=38)

# 打印的时候会以字典的形式打印

print(g2)

print(b2)

"""

{'name': b'mercy', 'age': 37}

{'name': b'hanzo', 'age': 38}

"""

# 当然啦,也可以先声明,然后单独赋值

# 我们上面创建了 g1 和 b1,下面赋值

g1.name, g1.age = "mercy", 37

b1.name, b1.age = "hanzo", 38

print(g1)

print(b1)

"""

{'name': b'mercy', 'age': 37}

{'name': b'hanzo', 'age': 38}

"""

# 通过 Python 的字典赋值

# 显然它涉及数据转换,会有额外开销

# 不建议使用此方式

cdef Girl g3 = {"name": "mercy", "age": 37}

cdef Boy b3 = {"name": "hanzo", "age": 38}

print(g3)

print(b3)

"""

{'name': b'mercy', 'age': 37}

{'name': b'hanzo', 'age': 38}

"""

在 C 里面还存在结构体的嵌套:

struct Girl {

struct {

char *name;

int age;

} Person;

int length;

};

Cython 也是允许结构体嵌套的,但是定义必须要单独拿出来,什么意思呢?看个例子就明白了。

cdef struct Person:

char *name

int age

# Person 的定义必须要单独拿出来定义

# 不可以嵌套定义

cdef struct Girl:

Person person

int length

cdef Girl g = Girl(person=Person("mercy", 37), length=167)

print(g)

"""

{'person': {'name': b'mercy', 'age': 37}, 'length': 167}

"""

另外,当定义结构体的时候,字段的类型必须都是 C 的类型。

11.2 共同体

共同体的声明在 C 和 Cython 里面都和结构体类似,我们来看一下。

cdef union U1:

short n1

int n2

ctypedef union U2:

short n1

int n2

cdef U1 u1

u1.n2 = 0X1234_4321

print(u1.n1 == 0X4321) # True

cdef U2 u2

u2.n2 = 0X4321_1234

print(u2.n1 == 0X1234) # True

使用方法和结构体类似,关于共同体的具体知识这里就不多说了,可以查询 C 语言共同体相关的内容。总之它的目的是为了节省内存,一个结构体实例所占的内存,等于内部所有字段所占内存之和(当然还要考虑内存对齐);而一个共同体实例所占的内存,等于内部占用内存最大的字段。

cdef struct S:

short field1 # 2 字节

int field2 # 4 字节

ssize_t field3 # 8 字节

cdef union U:

short field1

int field2

ssize_t field3

cdef S s

cdef U u

# 等于所有字段所占内存之和

# 2 + 4 + 8 = 14,但由于存在内存对齐

# 所以是 16

print(sizeof(s)) # 16

# 最长字段所占的内存

# 因此是 8

print(sizeof(u)) # 8

因此共同体明显要省内存,但是修改某一个字段,会影响其它字段,因为字段之间共用一组内存。而结构体则不会,字段之间互不影响,因为它们使用的是不同的内存。

11.3 枚举

定义枚举也很简单,我们可以在多行中定义,也可以在单行中定义然后用逗号隔开。

# 相当于 C 的 enum COLOR1 {};